关于本书

Rust 语言真的好:连续八年成为全世界最受欢迎的语言、没有 GC 也无需手动内存管理、性能比肩 C++/C 还能直接调用它们的代码、安全性极高 - 总有公司说使用 Rust 后以前的大部分 bug 都将自动消失、全世界最好的包管理工具 Cargo 等等。但…

有人说: “Rust 太难了,学了也没用”

对于后面一句话我们持保留意见,如果以找工作为标准,那国内环境确实还不好,但如果你想成为更优秀的程序员或者是玩转开源,那 Rust 还真是不错的选择,具体原因见下一章。

至于 Rust 难学,那正是本书要解决的问题,如果看完后,你觉得没有学会 Rust,可以找我们退款,哦抱歉,这是开源书,那就退 🌟 吧 :)

如果看到这里,大家觉得这本书的介绍并没有吸引到你,不要立即放弃,强烈建议读一下进入 Rust 编程世界,那里会有不一样的精彩。

配套练习题

对于学习编程而言,读一篇文章不如做几道练习题,此话虽然夸张,但是也不无道理。既然如此,既读书又做练习题,效果会不会更好?再加上练习题是书本的配套呢? :P

- Rust 语言实战, Rust 语言圣经配套习题,支持中英双语,可以在右上角切换

创作感悟

截至目前,Rust 语言圣经已写了 170 余章,110 余万字,历经 1000 多个小时,每一个章节都是手动写就,没有任何机翻和质量上的妥协( 相信深入阅读过的读者都能体会到这一点 )。

曾经有读者问过 “这么好的书为何要开源,而不是出版?”,原因很简单:只有完全开源才能完美地呈现出我想要的教学效果。

总之,Rust 要在国内真正发展起来,必须得有一些追逐梦想的人在做着不计付出的事情,而我希望自己能贡献一份微薄之力。

但是要说完全无欲无求,那也是不可能的,看到项目多了一颗 🌟,那感觉…棒极了,因为它代表了读者的认可和称赞。

你们用指尖绘制的星空,那里繁星点点,每一颗都在鼓励着怀揣着开源梦想的程序员披荆斩棘、不断前行,不夸张的说,没有你们,开源世界就没有星光,自然也就不会有今天的开源盛世。

因此,我恳请大家,如果觉得书还可以,就在你的指尖星空绘制一颗新的 🌟,指引我们继续砥砺前行。这个人世间,因善意而美好。

最后,能通过开源在茫茫人海中与大家相识,这感觉真好 :D

🏆 贡献者

非常感谢本教程的所有贡献者,正是有了你们,才有了现在的高质量 Rust 教程!

🏆

|

EluvK |

AllanDowney |

🏅

|

JesseAtSZ |

Rustln |

1132719438 |

zongzi531 |

进入 Rust 编程世界

Rust 发展历程

Rust 最早是 Mozilla 雇员 Graydon Hoare 的个人项目。从 2009 年开始,得到了 Mozilla 研究院的资助,2010 年项目对外公布,2010 ~ 2011 年间实现自举。自此以后,Rust 在部分重构 -> 崩溃的边缘反复横跳(历程极其艰辛),终于,在 2015 年 5 月 15 日发布 1.0 版。

在紧锣密鼓的开发过程中,Rust 建立了一个强大且活跃的社区,形成一整套完善稳定的项目贡献机制(Rust 能够飞速发展,与这一点密不可分)。Rust 现在由 Rust 项目开发者社区 维护, Rust 基金会赞助支持。

大家可能疑惑 Rust 为啥用了这么久才到 1.0 版本?与之相比,Go 语言 2009 年发布,却在 2012 年仅用 3 年就发布了 1.0 版本。

- 首先,Rust 语言特性较为复杂,所以需要全盘考虑的问题非常多;

- 其次,Rust 当时的参与者太多,七嘴八舌的声音很多,众口难调,而 Rust 开发团队又非常重视社区的意见;

- 最后,一旦 1.0 快速发布,那绝大部分语言特性就无法再被修改,对于有完美强迫症的 Rust 开发者团队来说,某种程度上的不完美是不可接受的。

因此,Rust 语言用了足足 6 年时间,才发布了尽善尽美的 1.0 版本。

大家知道 Rust 的作者到底因为何事才痛下决心开发一门新的语言吗?

说来挺有趣,在 2006 年的某天,作者工作到精疲力尽后,本想回公寓享受下生活,结果发现电梯的程序出 Bug 崩溃了,要知道在国外,修理工可不像在中国那样随时待岗,还要知道,他家在 20 多楼!

最后,他选择了妥协,去酒店待几天等待电梯的修理。

当然,一般人可能就这样算了,毕竟忍几天就过去了嘛。但是这名伟大的程序员显然也不是一般人,他面对害他流离失所的电梯拿起了屠龙宝刀 - Rust。

自此,劈开一个全新的编程世界。

为何又来一门新语言?

简而言之,因为还缺一门无 GC 且无需手动内存管理、性能高、工程性强、语言级安全性以及能同时得到工程派和学院派认可的语言,而 Rust 就是这样的语言。你也可以回忆下熟悉的语言,看是不是有另外一门可以同时满足这些需求:)

至于 Rust 最为人诟病的点,那也就一个:学习曲线陡峭。不过当语言生态起来后,这都不算问题。

缓解内卷

有人说 Rust 作为新语言会增加内卷,其实恰恰相反,Rust 可以缓解内卷。为何不说 C++ 内卷,而说 Java、Python、JS 内卷?不就是后几个相对简单、上手容易嘛?而 Rust 怎么看也是 C++ 级别的上手难度。

其实从我内心不可告人的角度出发,并不希望 Rust 大众化,因为这样可以保饭碗、保薪资,还能拥有行业内的地位。但是从对 Rust 的喜爱角度出发,我还是希望能卷一些。不过,目前来看真的卷不动,现在全世界范围内 Rust 的需求都大于供给,特别是优秀的 Rust 程序员更是难寻。

与 Go 语言相比,成为一名优秀的 Rust 程序员所需的门槛高得多,例如融汇贯通 Rust 语言各种中高级特性、闭着眼睛趟过各种坑、不用回忆无需查找就能立刻写出最合适的包/模块/方法、性能/安全/工程性的权衡选择信手拈来、深层性能优化易如反掌、异步编程小菜一碟,更别说 Rust 之外的操作系统、网络、算法等等相关知识。

所以,Rust 可以缓解内卷,而不是增加内卷。可以说是程序员的福音,不再是被随意替换的螺丝钉。

效率

下面从三个角度来谈谈 Rust 的效率:学习、运行、开发。

学习效率

众所周知,Rust 的学习曲线相当陡峭。起初,对此说法我还嗤之以鼻,随着不断的深入,现在也很认可这个说法。Rust 之难,不在于语言特性,这些都可以很容易学到,而在于:

- 实践中如何融会贯通的运用

- 遇到了坑时(生命周期、借用错误,自引用等)如何迅速、正确的解决

- 大量的标准库方法记忆及熟练使用,这些是保证开发效率的关键

- 心智负担较重,特别是初中级阶段

好在这本书就是干这个的,包君满意,不满意退… 要不还是骂我吧 :D

运行效率

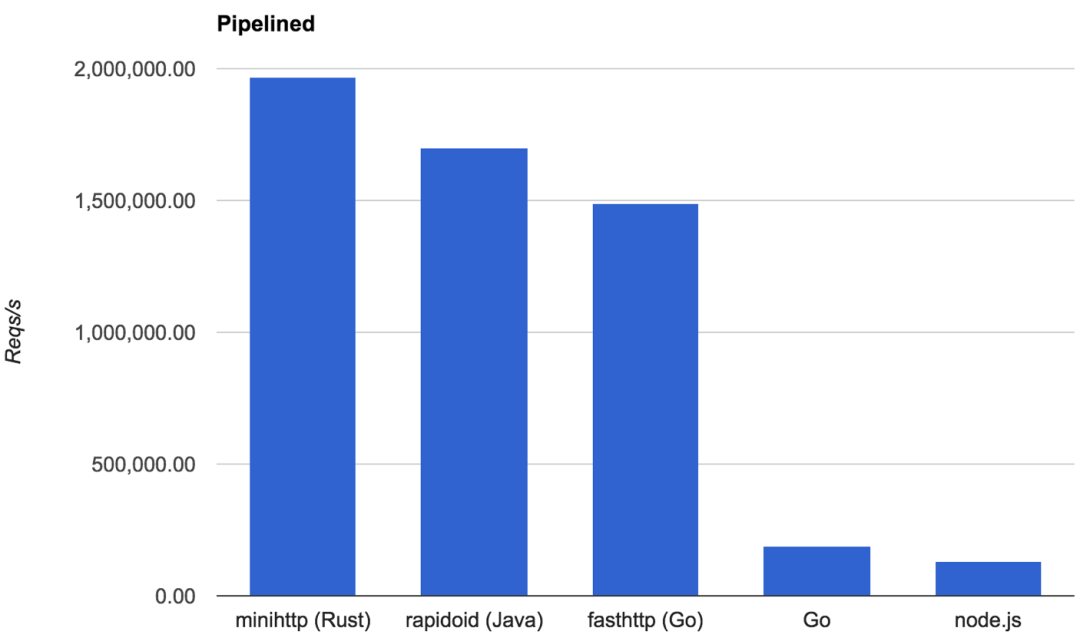

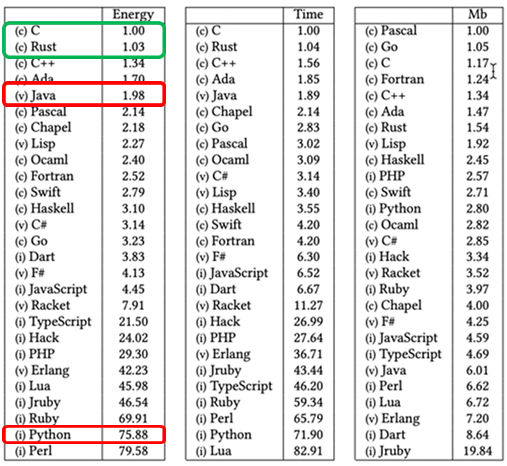

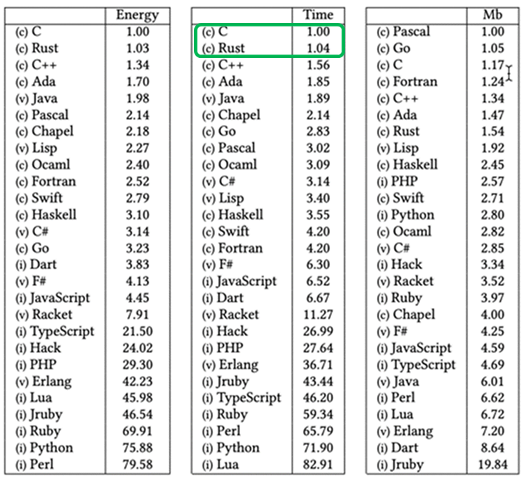

得益于各种零开销抽象、深入到底层的优化潜力、优质的标准库和第三方库实现,Rust 具备非常优秀的性能,和 C、C++ 是 一个级别。

同时 Rust 有一个极大的优点:只要按照正确的方式使用 Rust,无需性能优化,就能有非常优秀的表现,不可谓不惊艳。

现在有不少用 Rust 重写的工具、平台都超过了原来用 C、C++ 实现的版本,将老前辈拍死在沙滩上,俨然成为一种潮流~~

开发效率

Rust 的开发效率可以用先抑后扬来形容。在最初上手写项目时,你的开发速度将显著慢于 Go、Java 等语言,不过,一旦开始熟悉标准库、熟悉生命周期和所有权的常用解决方法,开发效率将大幅提升,甚至当形成肌肉记忆后,开发效率将不会慢于这些语言,而且原生就能写出高质量、安全、高效的代码,可以说中高级 Rust 程序员就是高效程序员的代名词。

个人的好处

学习 Rust 对个人也有极大的好处。

成为更好的程序员

要学好 Rust,你需要深入理解内存、堆栈、引用、变量作用域等这些其它高级语言往往不会深入接触的内容。另外,Rust 会通过语法、编译器和 clippy 这些静态检查工具半帮助半强迫的让你成为更优秀的程序员,写出更好的代码。

同时,当你掌握 Rust 后,就会自发性的想要去做一些更偏底层的开发,这些都可以帮助你更加了解操作系统、网络、性能优化等底层知识,也会间接或者直接的接触到各种算法和数据结构的实现。

慢慢的,你就在成为那个更好的程序员,也是更优秀的自己。

增加不可替代性

语言难学也有好处,一旦掌握,你将具备较强的不可替代性,不再是一个简单的工具人角色。看看现在内卷严重的 Java,工具人有多少!一个人离职,另外一个人很快就能替补上。

当然,我不是说 Rust 会给公司带来这种隐形的维护成本,毕竟这其实是一种双赢,公司收获了更优秀的程序员(不可否认的是 Rust 程序员普遍来说水平确实更高,毕竟都是有很好的编程基础、也很有追求的自驱型人才),而你也收获了更稳定的工作环境,甚至是更高的收入。

团队的好处

先不说安全、可靠性等对公司团队非常友好的特性,就说 Rust 程序只要能跑起来,那代码质量其实就是相当不错的,因为 Rust 编译器实在是一名严师厉友,甚至有些鸡毛。

正因为这较高的质量下限,我们在代码 review 时不用过于担心潜在的各种坑,得益于此,可以实现更加高效的开发、review、merge 流程。

由于 Rust 语言拥有异常强大的编译器和语言特性,Rust 的代码天然就会比其它语言拥有更少的 Bug。同时 Rust 拥有非常完善的工具链、最好的包管理工具,决定了 Rust 非常适合大型团队的协作开发。

也许 Rust 在开发速度上不是最快的,但是从开发 + 维护的角度来看,这个成本在各个语言中绝对是很小的。当然,如果你的公司就追求做出来能用就行,那 Rust 确实有些灰姑娘的感觉。

还有一点很重要,现在的 Rust 程序员往往拥有更出众的能力和学习自驱性,因此团队招到的人天然就保持了较高的底线。如果你有幸招到一个优秀的 Rust 程序员,那真是捡到宝了,他也会同时带动周围的人一起慢慢优秀(优秀的 Rust 程序员比较好辨别,门槛低的语言就并没有那么好辨别)。总之,一个这样的程序员会给团队带来远超他薪资的潜在回报和长远收益。

开源

目前 Rust 的主战场是在开源上,Go 的成功也证明了农村包围城市( 开源包围商业 )的可行性。

- UI 层开发,Rust 的 WASM 发展的如火如荼,隐隐有王者风范,在 JS 的基础设施领域,Rust 也是如鱼得水,例如

swc、deno等。同时nextjs也是押宝 Rust,可以说 Rust 在前端的成功完全是无心插柳柳成荫。 - 基础设施层、数据库、搜索引擎、网络设施、云原生等都在出现 Rust 的身影,而且还不少。

- 系统开发,目前 Linux 已经将 Rust 语言纳入内核,是继 C 语言后第二门支持内核开发的语言,不过刚开始将主要支持驱动开发。

- 系统工具,现在最流行的就是用 Rust 重写之前 C、C++ 写的一票系统工具,还都获得了挺高的关注和很好的效果,例如 sd, exa, ripgrep, fd, bat 等。

- 操作系统,正在使用 Rust 开发的操作系统有好几个,其中最有名的可能就是谷歌的 Fuchsia,Rust 在其中扮演非常重要的角色。

- 区块链,如果 Rust 的份额说第二,应该没人敢稳说自己是第一吧?

类似的还有很多,我们就不一一列举。总之,现在有大量的项目正在被 Rust 重写,同时还有海量的项目在等待被重写,这些都是赚取 github 星星和认可的好机会。在其它语言杀成一片红海时,Rust 还留了一大片蓝海等待大家的探索!

相比其他语言 Rust 的优势

由于篇幅有限,我们这里不会讲述详细的对比,就是简单介绍下 Rust 的优势,并不是说 Rust 优于这些语言,大家轻喷:)

Go

Rust 语言表达能力更强,性能更高。同时线程安全方面 Rust 也更强,不容易写出错误的代码。包管理 Rust 也更好,Go 虽然在 1.10 版本后提供了包管理,但是目前还比不上 Rust 。

C++

Rust 与 C++ 的性能旗鼓相当,但是在安全性方面 Rust 会更优,特别是使用第三方库时,Rust 的严格要求会让三方库的质量明显高很多。

语言本身的学习,Rust 的前中期学习曲线会更陡峭,但是在实际的项目开发过程中,C++ 会更难,代码也更难以维护。

Java

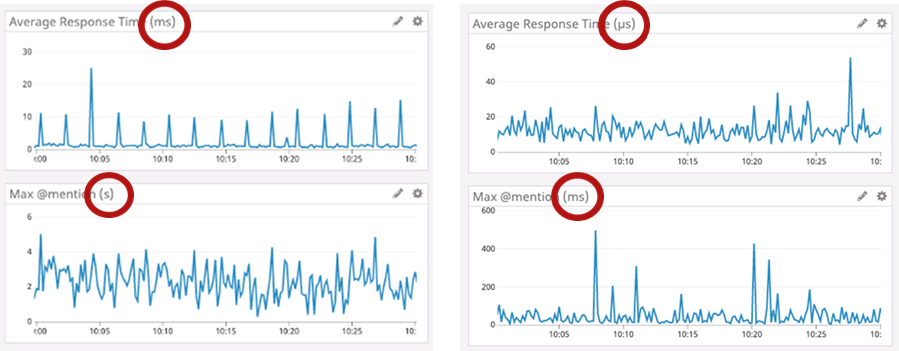

除了极少数纯粹的数字计算性能,Rust 的性能全面领先于 Java 。同时 Rust 占用内存小的多,因此实现同等规模的服务,Rust 所需的硬件成本会显著降低。

Python

性能自然是 Rust 完胜,同时 Rust 对运行环境要求较低,这两点差不多就足够抉择了。不过 Python 和 Rust 的彼此适用面其实也不太冲突。

使用现状

- AWS 从 2017 年开始就用 Rust 实现了无服务器计算平台: AWS Lambda 和 AWS Fargate,并且用 Rust 重写了 Bottlerocket OS 和 AWS Nitro 系统,这两个是弹性计算云 (EC2) 的重要服务

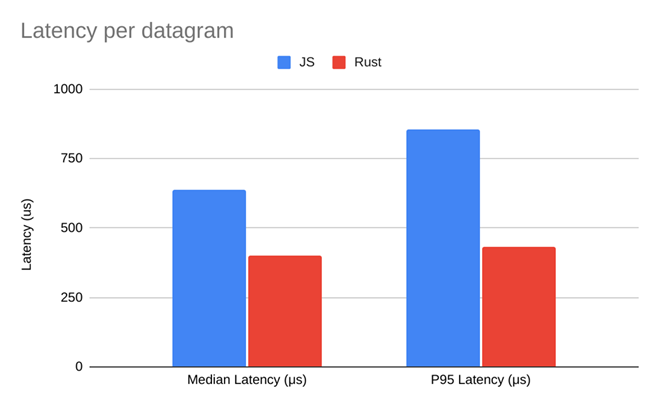

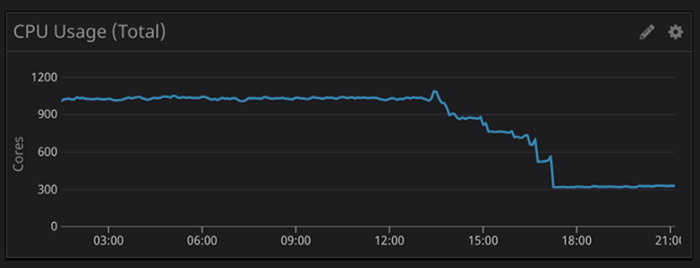

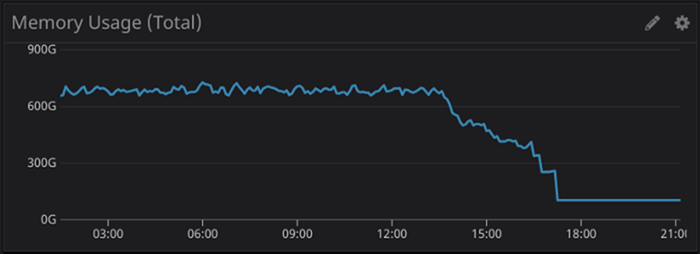

- Cloudflare 是 Rust 的重度用户,DNS、无服务计算、网络包监控等基础设施都与 Rust 密不可分

- Dropbox 的底层存储服务完全由 Rust 重写,达到了数万 PB 的规模

- Google 除了在安卓系统的部分模块中使用 Rust 外,还在它最新的操作系统 Fuchsia 中重度使用 Rust

- Facebook 使用 Rust 来增强自己的网页端、移动端和 API 服务的性能,同时还写了 Hack 编程语言的虚拟机

- Microsoft 使用 Rust 为 Azure 平台提供一些组件,其中包括 IoT 的核心服务

- GitHub 和 npmjs.com,使用 Rust 提供高达每天 13 亿次的 npm 包下载

- Rust 目前已经成为全世界区块链平台的首选开发语言

- TiDB,国内最有名的开源分布式数据库

尤其值得一提的是,AWS 实际上在押宝 Rust,内部对 Rust 的使用已经上升到头等公民 first-class 的地位。

Rust 语言版本更新

与其它语言相比,Rust 的更新迭代较为频繁(得益于精心设计过的发布流程以及 Rust 语言开发者团队的严格管理):

- 每 6 周发布一个迭代版本

- 2-3 年发布一个新的大版本,例如 Rust 2018 edition,Rust 2021 edition

好处在于,可以满足不同的用户群体的需求:

- 对于活跃的 Rust 用户,他们总是能很快获取到新的语言内容,毕竟,尝鲜是技术爱好者的共同特点:)

- 对于一般的用户,edition 大版本的发布会告诉他们:Rust 语言相比上次大版本发布,有了重大的改进,值得一看

- 对于 Rust 语言开发者,可以让他们的工作成果更快的被世人所知,不必锦衣夜行

总结

连续 8 年最受欢迎的语言当然不是浪得虚名。 无 GC、效率高、工程性强、强安全性以及能同时得到工程派和学院派认可,这些令 Rust 拥有了自己的特色和生存空间。社区的友善,生态的快速发展,大公司的重仓跟进,一切的一切都在说明 Rust 的璀璨未来。

当然,语言毕竟只是工具,我们不能神话它,但是可以给它一个机会,也许,你最终能收获自己的真爱 :)

相信大家听了这么多 Rust 的优点,已经迫不及待想要开始学习旅程,那么容我引用一句 CS(Counter-Strike:反恐精英) 的经典台词:Ok, Let’s Rust.

本书是完全开源的,但是并不意味着质量上的妥协,这里的每一个章节都花费了大量的心血和时间才能完成,为此牺牲了陪伴家人、日常娱乐的时间,虽然我们并不后悔,但是如果能得到读者您的鼓励,我们将感激不尽。

既然是开源,那最大的鼓励不是 money,而是 star:) 如果大家觉得这本书作者真的用心了,就帮我们点一个 🌟 吧,这将是我们继续前行的最大动力

避免从入门到放弃

很多人都在学 Rust ing,也有很多人在放弃 ing。想要顺利学完 Rust,大家需要谨记本文列出的内容,否则这极有可能是又双叒叕从入门到放弃之旅。

Rust 是一门全新的语言,它会带给你前所未有的体验,提升你的通用编程水平,甚至于赋予你全新的编程思想。在此时此刻,大家可能还半信半疑,但是当学完它再回头看时,你肯定也会认同这些貌似浮夸的赞美。

避免试一试的心态

在学习 Go、Python 等编程语言时,你可能会一边工作、一边轻松愉快的学习它们,但是 Rust 不行。原因如文章开头所说,在学习 Rust 的同时你会收获很多语言之外的知识,因此 Rust 在入门阶段比很多编程语言要更难,但是一旦入门,你将收获一个全新的自己,成为一个更加优秀的程序员。

在学习过程中,一开始可能会轻松愉快,但是在开始接触 Rust 核心概念时(所有权、借用、生命周期、智能指针等),难度会陡然提升,此时就需要认真对待起来,否则会为后面埋下难以填补的坑:结果最后你可能只有两个选择 —— 重新学 or 放弃。

因此,在学习过程中,给大家三点建议:

- 要提前做好会遇到困难的准备,因为如上所说,学习 Rust 不仅仅是在学习一门编程语言

- 不要抱着试一试的心态去试一试,否则是浪费时间和消耗学习激情,作为连续七年荣获全世界最受喜欢桂冠的语言,Rust 不仅仅是值得试一试 :)

- 深入学习一本好书或教程

总之,Rust 入门难,但是在你一次次克服艰难险阻的同时,也一次次收获了与众不同的编程经验,最后历经九九八十一难,立地成大佬。 给自己一个机会,也给 Rust 一个机会 :)

深入学习一本好书

Rust 跟其它语言不同,你无法看了一遍语法,然后就能上手写代码,对,我说的就是对比 Go 语言,后者的简单易用是有目共睹的。

这些年,我遇到过太多在网上看了一遍菜鸟教程(或其它简易教程)就上手写 demo 甚至项目的同学,无一例外,都各种碰壁、趟坑,最后要么放弃,要么回炉重造,之前的时间和精力基本等同浪费。

因此,大家一定要舍得投入时间,沉下心去读一本好书,这本书会带你深入浅出地学习使用 Rust 所需的各种知识,还会带你提前趟坑,这些坑往往是需要大量的时间才能领悟的。

在以前我可能会推荐看 Rust Book + async book + nomicon 这几本英文书的组合,但是现在有了一本更适合中国用户的书籍,那就是…你们猜,内容好坏大家一读即知,光就文字而言,那绝对是行云流水般的阅读体验,可以极大提升学习效率,也不再因为反复读也读不懂一句话而烦闷不堪。

千万别从链表或图开始练手

CS(Computer Science:计算机科学)课程中咱们会学习大量的常用数据结构和算法,因此大家都养成了一种好习惯:学习一门新语言,先用它写个链表或图试试。

我的天,在 Rust 中千万别这么干,你是在扼杀自己之前的努力!因为不像其它语言,链表在 Rust 中简直是地狱一般的难度,我见过太多英雄好汉难过链表关,最终黯然退幕。我不希望正在阅读此文的你也成为其中一个 :(

这些自引用类型(一种数据结构,它内部的某个字段又引用了其自身),它们堪称恶魔:不仅仅在蹂躏着新手,还在折磨着老手。有意思的是,它们的难恰恰是 Rust 的优点导致的:无 GC 也无手动内存管理还要做到内存安全。

这些优点并不是凭空产生,而是来源于 Rust 那一套强大、优美的机制,这些机制一旦你学到,就会被它巧妙的构思和设计征服,进而被 Rust 深深吸引!但是一切选择都有利弊,这种机制的弊端就在于实现链表这类数据结构时,会变得非常非常复杂。

你需要糅合各种知识,才能解决这个问题,但是这显然不是一个新手应该独自去面对的。总之,不会链表对于 Rust 的学习和写项目,真的没有任何影响,直接使用大神已经写好的数据结构就可以。

如果想要练手,我们可以换个方向开始,例如书中的入门和进阶实战项目都是非常好的选择。当然如果你就是喜欢征服困难,那没问题,就从链表开始。但是无论选择哪个,本书都将给你莫大的帮助,包括如何实现一个链表!

仔细阅读编译错误

在一些编程语言中,你可能习惯了编译器给出的错误只看前面(或后面)几行,毕竟大部分是没啥大用的堆栈信息,在此过程中, how stupid the 编译器 is 的感想时不时会迸发出来。

但是 Rust 不是,它为我们提供了一个强大无比的编译器,而且会提示我们该如何修改代码以解决错误,简直就是一名优秀的老师!

因此在使用 Rust 过程中,如果你不知该如何解决错误,不妨仔细阅读下编译器或者 IDE 给出的错误提示,绝大多数时候,都可以通过这些提示顺利的解决问题。

同时也不要忽略编译器给出的警告信息(warnings),因为里面包含了 cargo clippy 给出的 lint 提示,这些提示不仅仅包含代码风格,甚至包含了一些隐藏很深的错误!至于这些错误为何不是 error 形式出现,随着学习的深入,你将逐渐理解 Rust 的各种设计选择,包括这个问题。

不要强制自己使用其它编程语言的最佳实践来写 Rust

大多数其它编程语言适用的最佳实践在 Rust 中也可以很好的使用,但是 Rust 并不是一门专门的面向对象或者函数式语言,因此在使用自己喜欢的编程风格时,也要考虑遵循 Rust 应有的实践。

例如纯面向对象或纯函数式编程,在 Rust 中就并不是一个很好的选择。如果你有过 Go 语言的编程经验,相信能更加理解我这里想表达的含义。

不过大家也不用担心,在书中我们会以专题的形式专门讲解 Rust 的最佳实践,看完后自然就明白了。

总结

对于新手而言,最应该避免的就是从链表开始练手,最应该做的就是认真仔细地学习一本优秀而全面的书。

总之,认真学 Rust,既然选择了,就相信自己,你的前方会是星辰大海!

社区和锈书

Rust语言中文网

跟我来吧,学完 Rust,你的前面就是星辰大海!

这个社区与其它 Rust 社区有点不一样: 我们聚焦于 Rust 语言的学习研究和实战应用上,不搞花活!

-

RustCn 微信交流群

-

公众号:

Rust语言中文网

Rusty Book( 锈书 )

在 Rust 元宇宙,最优秀的项目可以称之为 rusty,用咱中国话来说,就是够锈( 秀 )。

如果你有以下需求,可以来看看锈书,它绝对不会让你失望:

-

想要知道现在优秀的、关注度高的 Rust 项目有哪些

-

发现一些好玩、有趣、酷炫的开源库

-

需要寻找某个类型的库,例如,一个 HTTP 客户端或 ProtoBuffer 编码库,要求是好用、更新活跃、高质量

-

想要寻找常用操作的代码片段,用于熟悉 Rust 或者直接复制粘贴到自己的项目中,例如文件操作、数据库操作、HTTP 请求、排序算法、正则等

Datav: 可编程的数据可视化平台和可观测性平台

经常关注新技术的同学,这两年应该都听说过可观测性这个概念,它包含了对 Metrics 指标、Log 日志以及 Trace 链路的监控,特别是针对这三个指标的深度关联,让监控数据不再孤立。

目前整个业界百花齐放,Prometheus、Jaeger、Opentelemetry 各种优秀的世界级开源产品覆盖了可观测性的方方面面,但是在可观测性的可视化方面还缺少一个大杀器,我们期待它能拥有以下特性:

- 覆盖各种可观测性场景

- 拥有丰富可定制选项的图表组件和数据源

- 图表、页面之间的深度可定义交互

- 企业级的多租户、权限管理、导航菜单和全局状态管理

- 优秀的图表性能和交互体验

- 现代化的的 UI 设计,支持数据大屏,完美支持移动端

- 强大的可编程性及二次开发友好性

- 宽松的开源协议、丰富的文档和快速的社区响应支持

这些特性每一个都不简单, Datav 就是为了解决这些问题而生。

Datav 不是全世界最好的可观测性和数据可视化平台,这毫无疑问,至少目前不是。但是它对开发者最友好,并且支持丰富的可编程性的平台

当一个产品它的代码结构清晰简洁、架构干净、使用的技术符合时代主流、文档齐全,当一个产品在各种使用细节上都为开发者专门设计过,当一个产品允许各种深度可定制时,我们可以称其开发者友好

Datav

Datav 是一个专为开发者打造的、可编程的可观测性平台,同时它还是 Grafana 的数据可视化平替。可以帮助用户快速在线构建监控、日志和链路跟踪等可观测性场景,可以不夸张的说,你想要的几乎任何监控可视化场景,Datav 都能帮你实现 ( 如果不行,大家可以提 issue ,合理的需求秒支持 )。

- 开源地址:https://github.com/data-observe/datav

- 官方网站:https://datav.io

- 在线 Demo: https://play.datav.io

开发语言

Datav 目前由以下部分组成:

- UI: React + Typescript + Vitejs

- API 、数据处理和 UI 静态文件服务: Go

- 插件管理: Go

- 数据采集 Agent: Rust

写在最后的感悟

Rust course 开源迄今快 2 年了,我没有收过一分钱的赞赏,曾经有过这个想法,但最终还是被自己否定了。不是因为有多高尚,只是真心希望能为国内的开源做一些微不足道的、不那么金钱相关的贡献。

回头看,现在能获得这么多 Star ,已经远远超出了我当初的预期。说句真心话,这本书的质量配不上这么多 star,毕竟有那么多非常优秀的开源产品都没能获得配的上它们质量的认可度和曝光度。

但可能因为天时地利人和,Rust course 走到了今天这一步,无论如何,非常感谢每一个贡献者,也感谢每一个点了 star 支持本书的读者,你们是最棒的!

正因为对开源的坚持,尽管是拥有近百万行代码的复杂平台,Datav 依然选择了 Apache2.0 作为开源协议,我不希望大家在使用它时,还担心未来商业化潜在的风险。

总之,开源这条路我会坚定走下去,为国为民的大话不敢说,但至少我会尽自己的一份力量,为国内的开源做一些力所能及的贡献。

BeatAI: 工程师 AI 入门圣经

Beat AI

专属于软件开发工程师的 AI 入门圣经。从神经网络到大模型,从高层设计到微观原理,从工程实现到算法,学完后,你会发现 AI 也并不是想象中那么高不可攀、无法战胜,Just beat it !

目前进度

准备开始动笔,预计在 2024.08 之前会完成基本的章节。

关于作者

作者并不是写书的小白,已经有一本 <<Rust语言圣经>> ,在 Rust 领域是目前最火的书籍,备受好评。

Q & A

Q: 为什么又双叒叕写一本 AI 入门书籍?

A: 一般来说,懂 AI 的往往并不深入懂工程,而精通工程的又不太懂 AI,我们的目的就是填补这个 gap,以工程师的角度来呈现 AI 的相关知识体系。

Q: 不懂数学可以学吗

A: 一本优秀的书籍它应该是层次丰富、结构清晰、深入浅出、通俗易懂的,能满足不同读者群体的需求。本书也是,就算读者大大不懂数学,无非就是无法深入到算法层面,但是并不妨碍深入学习理解 AI,我们也会对算法进行一些深入浅出的趣味讲解。

Q: 没有软件开发的背景,不太懂工程,也不懂数学,能学吗?

A: 答案基本同上,千人千面,各有所获。

寻找牛刀,以便小试

其实对于写这种章节,我内心是拒绝的,因为真的很无趣。对于一本书而言,这也更像是一种浪费纸张的行为(好在咱无纸化 :-D)。不过没有办法,如果不安装 Rust 环境,总不能让大家用空气运行吧,so,我恶趣味的起了一个这样的章节名。

在本章中,你将学习以下内容:

- 在 macOS、Linux、BSD 及 Windows 上安装 Rust 以及相关工具链

- 搭建 VSCode 所需的环境

- 简单介绍 Cargo

- 实现一个酷炫多国语言版本的“世界,你好”的程序,并且谈谈对 Rust 语言的初印象

安装 Rust

rustup 是 Rust 的安装程序,也是它的版本管理程序。

强烈建议使用 rustup 来安装 Rust,当然如果你有异心,请寻找其它安装方式,然后再从下一节开始阅读。

haha,开个玩笑。读者乃大大,怎么能弃之不顾。

注意:如果你不想用或者不能用 rustup,请参见 Rust 其它安装方法。

至于版本,现在 Rust 稳定版特性越来越全了,因此下载最新稳定版本即可。由于你用的 Rust 版本可能跟本书写作时不一样,一些编译错误和警告可能也会有所不同。

在 Linux 或 macOS 上安装 rustup

打开终端并输入下面命令:

$ curl --proto '=https' --tlsv1.2 https://sh.rustup.rs -sSf | sh

这个命令将下载一个脚本并开始安装 rustup 工具,此工具将安装 Rust 的最新稳定版本。可能会提示你输入管理员密码。

如果安装成功,将出现下面这行:

Rust is installed now. Great!

OK,这样就已经完成 Rust 安装啦。

安装 C 语言编译器:(非必需)

Rust 对运行环境的依赖和 Go 语言很像,几乎所有环境都可以无需安装任何依赖直接运行。但是,Rust 会依赖 libc 和链接器 linker。所以如果遇到了提示链接器无法执行的错误,你需要再手动安装一个 C 语言编译器:

macOS 下:

$ xcode-select --install

Linux 下:

Linux 用户一般应按照相应发行版的文档来安装 GCC 或 Clang。

例如,如果你使用 Ubuntu,则可安装 build-essential。

在 FreeBSD 上安装 rustup

- 使用 pkg 安装:

# pkg install rustup-init

- 使用 Ports 安装:

# cd /usr/ports/devel/rustup-init/

# make install clean

在 Windows 上安装 rustup

Windows 上安装 Rust 需要有 C++ 环境,以下为安装的两种方式:

1. x86_64-pc-windows-msvc(官方推荐)

先安装 Microsoft C++ Build Tools,勾选安装 C++ 环境即可。安装时可自行修改缓存路径与安装路径,避免占用过多 C 盘空间。安装完成后,Rust 所需的 msvc 命令行程序需要手动添加到环境变量中,否则安装 Rust 时 rustup-init 会提示未安装 Microsoft C++ Build Tools,其位于:%Visual Studio 安装位置%\VC\Tools\MSVC\%version%\bin\Hostx64\x64(请自行替换其中的 %Visual Studio 安装位置%、%version% 字段)下。

如果你不想这么做,可以选择安装 Microsoft C++ Build Tools 新增的“定制”终端 Developer Command Prompt for %Visual Studio version% 或 Developer PowerShell for %Visual Studio version%,在其中运行 rustup-init.exe。

准备好 C++ 环境后开始安装 Rust:

在 RUSTUP-INIT 下载系统相对应的 Rust 安装程序,一路默认即可。

PS C:\Users\Hehongyuan> rustup-init.exe

......

Current installation options:

default host triple: x86_64-pc-windows-msvc

default toolchain: stable (default)

profile: default

modify PATH variable: yes

1) Proceed with installation (default)

2) Customize installation

3) Cancel installation

2、x86_64-pc-windows-gnu

相比于 MSVC 版本来说,GNU 版本具有更轻量,更靠近 Linux 的优势。

首先,根据 MSYS2 官网 配置 MSYS。

若您觉得下载太慢,可以试试由 Caviar-X 提供的 代理。

在安装 mingw-toolchain 后,请将 %MSYS 安装路径%\mingw64\bin 添加到系统变量 PATH 中。

配置好后,在 MSYS 中输入下面的命令来安装 rustup。

$ curl https://sh.rustup.rs -sSf | sh

之后,根据以下输出进行配置。

Current installation options:

default host triple: x86_64-pc-windows-msvc

default toolchain: stable (default)

profile: default

modify PATH variable: yes

1) Proceed with installation (default)

2) Customize installation

3) Cancel installation

>2

I'm going to ask you the value of each of these installation options.

You may simply press the Enter key to leave unchanged.

Default host triple? [x86_64-pc-windows-msvc]

x86_64-pc-windows-gnu

Default toolchain? (stable/beta/nightly/none) [stable]

stable

Profile (which tools and data to install)? (minimal/default/complete) [default]

complete

Modify PATH variable? (Y/n)

Y

Current installation options:

default host triple: x86_64-pc-windows-gnu

default toolchain: stable

profile: complete

modify PATH variable: yes

1) Proceed with installation (default)

2) Customize installation

3) Cancel installation

>

再之后,按下 1,等待。完成后,您就已经安装了 Rust 和 rustup。

更新

要更新 Rust,在终端执行以下命令即可更新:

$ rustup update

卸载

要卸载 Rust 和 rustup,在终端执行以下命令即可卸载:

$ rustup self uninstall

检查安装是否成功

检查是否正确安装了 Rust,可打开终端并输入下面这行,此时能看到最新发布的稳定版本的版本号、提交哈希值和提交日期:

$ rustc -V

rustc 1.56.1 (59eed8a2a 2021-11-01)

$ cargo -V

cargo 1.57.0 (b2e52d7ca 2021-10-21)

注:若发现版本号不同,以您的版本号为准

恭喜,你已成功安装 Rust!

如果没看到此信息:

- 如果你使用的是 Windows,请检查 Rust 或

%USERPROFILE%\.cargo\bin是否在%PATH%系统变量中。 - 如果你使用的是 Windows 下的 Linux 子系统,请关闭并重新打开终端,再次执行以上命令。

如果都正确,但 Rust 仍然无法正常工作,那么你可以在很多地方获得帮助。最简单的是加入 Rust 编程学院这个大家庭,QQ 群:1009730433.

本地文档

安装 Rust 的同时也会在本地安装一个文档服务,方便我们离线阅读:运行 rustup doc 让浏览器打开本地文档。

每当遇到标准库提供的类型或函数不知道怎么用时,都可以在 API 文档中查找到!具体参见 在标准库寻找你想要的内容。

墙推 VSCode!

墙推 VSCode!

VSCode 从 15 年刚开始推出,我就在使用了。做为第一个吃螃蟹的人,可以说见证了它一路的快速发展,直到现在它已经成为开源世界最火的 IDE 之一(弱弱的说一句,之一也许可以去掉)。

顺便歪楼说一句:我预言过三件事:

- 在 13 年预言

Golang会火遍全世界。同时创建了 14-19 年最火的 Golang 隐修会社区,可惜因为某些原因被封停了,甚是遗憾。 - 在 15 年预言

VSCode会成为世界上最好的 IDE;同时我还是jaeger tracing项目的第一个 star 用户(是的,比作者还早),当时就很看好这个项目的后续发展。 - 现在呢,我在这里正式预言: 未来

Rust会成为主流编程语言之一,在几乎所有开发领域都将大放光彩。总之牛逼已吹下,希望不要被打脸。:(

下面继续简单介绍下 VSCode,以下内容引用于官网:

Visual Studio Code(VSCode) 是微软 2015 年推出的一个轻量但功能强大的源代码编辑器,基于 Electron 开发,支持 Windows、Linux 和 macOS 操作系统。它内置了对 JavaScript,TypeScript 和 Node.js 的支持并且具有丰富的其它语言和扩展的支持,功能超级强大。Visual Studio Code 是一款免费开源的现代化轻量级代码编辑器,支持几乎所有主流的开发语言的语法高亮、智能代码补全、自定义快捷键、括号匹配和颜色区分、代码片段、代码对比 Diff、GIT 命令等特性,支持插件扩展,并针对网页开发和云端应用开发做了优化。

安装 VSCode 的 Rust 插件

在 VSCode 的左侧扩展目录里,搜索 rust, 你能看到两个 Rust 插件,如果没有意外,这两个应该分别排名第一和第二:

- 官方的

Rust,作者是The Rust Programming Language, 官方出品,牛逼就完了,但是……我们并不推荐(事实上已经不再维护了,官方收编了第二个插件,现在第二个插件的作者也是The Rust Programming Language),这个插件有几个问题:

- 首先是在代码跳转上支持的很烂,只能在自己的代码库中跳转,一旦跳到别的三方库,那就无法继续跳转,对于查看标准库和三方库的源码带来了极大的困扰

- 其次,不支持类型自动标注,对于 Rust 语言而言,类型说明是非常重要的,特别是在你不知道给变量一个什么类型时,这种 IDE 的自动提示就变得弥足珍贵

- 代码提示不太好用,有些方法既不会提示,也不能跳转

- 社区驱动的

rust-analyzer,非常推荐,上面说的所有问题,在这个插件上都得到了解决,不得不说,Rust 社区 yyds!

所以,综上所述,我们选择 rust-analyzer 作为 Rust 语言的插件,具体的安装很简单,点击插件,选择安装即可,根据提示可能需要重新加载 IDE。

在搜索 VSCode 插件时,报错:

提取扩展出错,XHR failed,这个报错是因为网络原因导致,很可能是你的网络不行或者翻墙工具阻拦你的访问,试着关掉翻墙,再进行尝试。

安装完成后,在第一次打开 Rust 项目时,需要安装一些依赖,具体的状态在左下角会进行提示,包括下载、代码构建、building 等。

当插件使用默认设置时,每一次保存代码,都会进行一次重新编译。

如果你的电脑慢,有一点一定要注意:

在编译器构建代码的同时,不要在终端再运行

cargo run等命令进行编译,不然会获得一个报错提示,大意是当前文件目录已经被锁定,等待其它使用者释放。如果等了很久 IDE 还是没有释放(虽然我没遇到过,但是存在这个可能性),你可以关掉 IDE,并手动kill掉rust-analyzer,然后重新尝试。

安装其它好用的插件

在此,再推荐大家几个好用的插件:

Even Better TOML,支持 .toml 文件完整特性Error Lens, 更好的获得错误展示One Dark Pro, 非常好看的 VSCode 主题CodeLLDB, Debugger 程序

好了,至此,VSCode 的配置就已经全部结束,是不是很简单?下面让我们来用 Cargo 创建一个 Rust 项目,然后用 VSCode 打开。

认识 Cargo

认识 Cargo

但凡经历过 C/C++ 或 Go 语言 1.10 版本之前的用户都知道,一个好的包管理工具有多么的重要!!我那个时候是如此的渴望类似 nodejs 的 npm 包管理工具,但是却求而不得。

包管理工具最重要的意义就是任何用户拿到你的代码,都能运行起来,而不会因为各种包版本依赖焦头烂额。

Go 语言在 1.10 版本之前,所有的包都是在 github.com 下存放,导致了所有的项目都公用一套依赖代码,在本地项目复杂后,这简直是一种灾难。

说多了都是泪,笔者目前还有一个早期 Go 的项目(15 年写的),用到了 iris (一个坑爹 HTTP 服务),结果现在运行不起来了,因为找不到 iris 当时的那个版本了!!

作为一门现代化语言,Rust 吸收了多个语言的包管理优点,为大家提供超级大杀器: cargo,真的,再挑剔的开发者,都对它赞不绝口。👍

总而言之,cargo 提供了一系列的工具,从项目的建立、构建到测试、运行直至部署,为 Rust 项目的管理提供尽可能完整的手段。同时,与 Rust 语言及其编译器 rustc 紧密结合,可以说用了后就忘不掉,如同初恋般的感觉。

创建一个“你好,世界“项目

又见“你好,世界“,肯定有读者在批评了:你就不能有点创意吗?“世界,你好“难道不配?你是读者,你说了算,那我们就来创建一个“世界,你好”。

上文提到,Rust 语言的包管理工具是 cargo。不过,我们无需再手动安装,之前安装 Rust 的时候,就已经一并安装了。

终于到了紧张刺激的 new new new 环节:

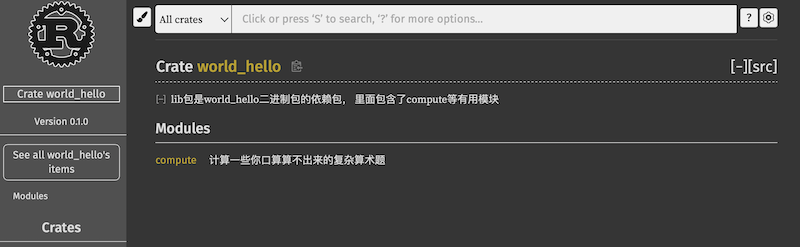

$ cargo new world_hello

$ cd world_hello

上面的命令使用 cargo new 创建一个项目,项目名是 world_hello (向读者势力低头的项目名称,泪奔),该项目的结构和配置文件都是由 cargo 生成,意味着我们的项目被 cargo 所管理。

如果你在终端无法使用这个命令,考虑一下

环境变量是否正确的设置:把cargo可执行文件所在的目录添加到环境变量中。如果是在 Windows 的 WSL2 子系统下,出现以下错误:

error: command failed: 'rustc'error: caused by: Permission denied (os error 13)可尝试先卸载,再使用

sudo命令进行安装:$ sudo curl --proto '=https' --tlsv1.2 https://sh.rustup.rs -sSf | sh

早期的 cargo 在创建项目时,必须添加 --bin 的参数,如下所示:

$ cargo new world_hello --bin

$ cd world_hello

现在的版本,已经无需此参数,cargo 默认就创建 bin 类型的项目,顺便说一句,Rust 项目主要分为两个类型:bin 和 lib,前者是一个可运行的项目,后者是一个依赖库项目。

下面来看看创建的项目结构:

$ tree

.

├── .git

├── .gitignore

├── Cargo.toml

└── src

└── main.rs

是的,连 git 都给你创建了,不禁令人感叹,不是女儿,胜似女儿,比小棉袄还体贴。

运行项目

有两种方式可以运行项目:

-

cargo run -

手动编译和运行项目

首先来看看第一种方式,一码胜似千言,在之前创建的 world_hello 目录下运行:

$ cargo run

Compiling world_hello v0.1.0 (/Users/sunfei/development/rust/world_hello)

Finished dev [unoptimized + debuginfo] target(s) in 0.43s

Running `target/debug/world_hello`

Hello, world!

好了,你已经看到程序的输出:"Hello, world"。

如果你安装的 Rust 的 host triple 是 x86_64-pc-windows-msvc 并确认 Rust 已经正确安装,但在终端上运行上述命令时,出现类似如下的错误摘要 linking with `link.exe` failed: exit code: 1181,请使用 Visual Studio Installer 安装 Windows SDK。

可能有读者不愿意了,说好了“世界,你好“呢?别急,在下一节,我们再对代码进行修改。(认真想来,“你好,世界“强调的是我对世界说你好,而“世界,你好“是世界对我说你好,明显是后者更有包容性和国际范儿,读者真·好眼光。)

上述代码,cargo run 首先对项目进行编译,然后再运行,因此它实际上等同于运行了两个指令,下面我们手动试一下编译和运行项目:

编译

$ cargo build

Finished dev [unoptimized + debuginfo] target(s) in 0.00s

运行

$ ./target/debug/world_hello

Hello, world!

行云流水,但谈不上一气呵成。 细心的读者可能已经发现,在调用的时候,路径 ./target/debug/world_hello 中有一个明晃晃的 debug 字段,没错我们运行的是 debug 模式,在这种模式下,代码的编译速度会非常快,可是福兮祸所伏,运行速度就慢了. 原因是,在 debug 模式下,Rust 编译器不会做任何的优化,只为了尽快的编译完成,让你的开发流程更加顺畅。

作为尊贵的读者,咱自然可以要求更多,比如你想要高性能的代码怎么办? 简单,添加 --release 来编译:

cargo run --releasecargo build --release

试着运行一下我们高性能的 release 程序:

$ ./target/release/world_hello

Hello, world!

cargo check

当项目大了后,cargo run 和 cargo build 不可避免的会变慢,那么有没有更快的方式来验证代码的正确性呢?大杀器来了,接着!

cargo check 是我们在代码开发过程中最常用的命令,它的作用很简单:快速的检查一下代码能否编译通过。因此该命令速度会非常快,能节省大量的编译时间。

$ cargo check

Checking world_hello v0.1.0 (/Users/sunfei/development/rust/world_hello)

Finished dev [unoptimized + debuginfo] target(s) in 0.06s

Rust 虽然编译速度还行,但是还是不能与 Go 语言相提并论,因为 Rust 需要做很多复杂的编译优化和语言特性解析,甚至连如何优化编译速度都成了一门学问: 优化编译速度。

Cargo.toml 和 Cargo.lock

Cargo.toml 和 Cargo.lock 是 cargo 的核心文件,它的所有活动均基于此二者。

-

Cargo.toml是cargo特有的项目数据描述文件。它存储了项目的所有元配置信息,如果 Rust 开发者希望 Rust 项目能够按照期望的方式进行构建、测试和运行,那么,必须按照合理的方式构建Cargo.toml。 -

Cargo.lock文件是cargo工具根据同一项目的toml文件生成的项目依赖详细清单,因此我们一般不用修改它,只需要对着Cargo.toml文件撸就行了。

什么情况下该把

Cargo.lock上传到 git 仓库里?很简单,当你的项目是一个可运行的程序时,就上传Cargo.lock,如果是一个依赖库项目,那么请把它添加到.gitignore中。

现在用 VSCode 打开上面创建的“世界,你好“项目,然后进入根目录的 Cargo.toml 文件,可以看到该文件包含不少信息:

package 配置段落

package 中记录了项目的描述信息,典型的如下:

[package]

name = "world_hello"

version = "0.1.0"

edition = "2021"

name 字段定义了项目名称,version 字段定义当前版本,新项目默认是 0.1.0,edition 字段定义了我们使用的 Rust 大版本。因为本书很新(不仅仅是现在新,未来也将及时修订,跟得上 Rust 的小步伐),所以使用的是 Rust edition 2021 大版本,详情见 Rust 版本详解

定义项目依赖

使用 cargo 工具的最大优势就在于,能够对该项目的各种依赖项进行方便、统一和灵活的管理。

在 Cargo.toml 中,主要通过各种依赖段落来描述该项目的各种依赖项:

- 基于 Rust 官方仓库

crates.io,通过版本说明来描述 - 基于项目源代码的 git 仓库地址,通过 URL 来描述

- 基于本地项目的绝对路径或者相对路径,通过类 Unix 模式的路径来描述

这三种形式具体写法如下:

[dependencies]

rand = "0.3"

hammer = { version = "0.5.0"}

color = { git = "https://github.com/bjz/color-rs" }

geometry = { path = "crates/geometry" }

相信聪明的读者已经能看懂该如何引入外部依赖库,这里就不再赘述。详细的说明参见此章:Cargo 依赖管理,但是不建议大家现在去看,只要按照目录浏览,拨云见日指日可待。

基于 cargo 的项目组织结构

前文有提到 cargo 默认生成的项目结构,真实的项目肯定会有所不同,但是在目前的学习阶段,还无需关注。感兴趣的同学可以移步:Cargo 项目结构

至此,大家对 Rust 项目的创建和管理已经有了初步的了解,那么来完善刚才的"世界,你好"项目吧。

不仅仅是 Hello world

几乎所有教程中安装的最后一个环节都是 hello world,我们也不能免俗。但是,在 hello world 之后,还有一个相亲,啊呸,Rust 初印象环节,希望大家喜欢。

多国语言的“世界,你好“

还记得大明湖畔等你的 VSCode IDE 和通过 Cargo 创建的 世界,你好 工程吗?

现在使用 VSCode 打开 上一节 中创建的 world_hello 工程,然后进入 main.rs 文件。(此文件是当前 Rust 工程的入口文件,和其它语言几无区别。)

接下来,对世界友人给予热切的问候:

fn greet_world() {

let southern_germany = "Grüß Gott!";

let chinese = "世界,你好";

let english = "World, hello";

let regions = [southern_germany, chinese, english];

for region in regions.iter() {

println!("{}", ®ion);

}

}

fn main() {

greet_world();

}打开终端,进入 world_hello 工程根目录,运行该程序。(你也可以在 VSCode 中打开终端,方法是点击 VSCode 上方菜单栏中的终端->新建终端,或者直接使用快捷键打开。)

$ cargo run

Compiling world_hello v0.1.0 (/Users/sunfei/development/rust/world_hello)

Finished dev [unoptimized + debuginfo] target(s) in 0.21s

Running `target/debug/world_hello`

Grüß Gott!

世界,你好

World, hello

你的热情,就像一把火,燃烧了整个世界~ 花点时间来看看上面的代码:

首先,Rust 原生支持 UTF-8 编码的字符串,这意味着你可以很容易的使用世界各国文字作为字符串内容。

其次,关注下 println 后面的 !,如果你有 Ruby 编程经验,那么你可能会认为这是解构操作符,但是在 Rust 中,这是 宏 操作符,你目前可以认为宏是一种特殊类型函数。

对于 println 来说,我们没有使用其它语言惯用的 %s、%d 来做输出占位符,而是使用 {},因为 Rust 在底层帮我们做了大量工作,会自动识别输出数据的类型,例如当前例子,会识别为 &str 类型。

最后,和其它语言不同,Rust 的集合类型不能直接进行循环,需要变成迭代器(这里是通过 .iter() 方法),才能用于迭代循环。在目前来看,你会觉得这一点好像挺麻烦,不急,以后就知道这么做的好处所在。

实际上这段代码可以简写,在 2021 edition 及以后,支持直接写

for region in regions,原因会在迭代器章节的开头提到,是因为 for 隐式地将 regions 转换成迭代器。

至于函数声明、调用、数组的使用,和其它语言没什么区别,So Easy!

Rust 语言初印象

Haskell 和 Java 开发者们可能会觉得Rust 这门语言很熟悉,因为它们在高阶表达方面都很优秀。简而言之,就是可以很简洁的写出原本需要一大堆代码才能表达的含义。但是,Rust 又有所不同:它的性能是底层语言级别的性能,可以跟 C/C++ 相媲美。

上面的 So Easy 的余音仍在绕梁,我希望它能继续下去,可是… 人总是要面对现实,因此让我们来点狠活:

fn main() {

let penguin_data = "\

common name,length (cm)

Little penguin,33

Yellow-eyed penguin,65

Fiordland penguin,60

Invalid,data

";

let records = penguin_data.lines();

for (i, record) in records.enumerate() {

if i == 0 || record.trim().len() == 0 {

continue;

}

// 声明一个 fields 变量,类型是 Vec

// Vec 是 vector 的缩写,是一个可伸缩的集合类型,可以认为是一个动态数组

// <_>表示 Vec 中的元素类型由编译器自行推断,在很多场景下,都会帮我们省却不少功夫

let fields: Vec<_> = record

.split(',')

.map(|field| field.trim())

.collect();

if cfg!(debug_assertions) {

// 输出到标准错误输出

eprintln!("debug: {:?} -> {:?}",

record, fields);

}

let name = fields[0];

// 1. 尝试把 fields[1] 的值转换为 f32 类型的浮点数,如果成功,则把 f32 值赋给 length 变量

//

// 2. if let 是一个匹配表达式,用来从=右边的结果中,匹配出 length 的值:

// 1)当=右边的表达式执行成功,则会返回一个 Ok(f32) 的类型,若失败,则会返回一个 Err(e) 类型,if let 的作用就是仅匹配 Ok 也就是成功的情况,如果是错误,就直接忽略

// 2)同时 if let 还会做一次解构匹配,通过 Ok(length) 去匹配右边的 Ok(f32),最终把相应的 f32 值赋给 length

//

// 3. 当然你也可以忽略成功的情况,用 if let Err(e) = fields[1].parse::<f32>() {...}匹配出错误,然后打印出来,但是没啥卵用

if let Ok(length) = fields[1].parse::<f32>() {

// 输出到标准输出

println!("{}, {}cm", name, length);

}

}

}看完这段代码,不知道你的余音有没有戛然而止,反正我已经在颤抖了。这就是传说中的下马威吗?😵

上面代码中,值得注意的 Rust 特性有:

- 控制流:

for和continue连在一起使用,实现循环控制。 - 方法语法:由于 Rust 没有继承,因此 Rust 不是传统意义上的面向对象语言,但是它却从

OO语言那里偷师了方法的使用record.trim(),record.split(',')等。 - 高阶函数编程:函数可以作为参数也能作为返回值,例如

.map(|field| field.trim()),这里map方法中使用闭包函数作为参数,也可以称呼为匿名函数、lambda 函数。 - 类型标注:

if let Ok(length) = fields[1].parse::<f32>(),通过::<f32>的使用,告诉编译器length是一个f32类型的浮点数。这种类型标注不是很常用,但是在编译器无法推断出你的数据类型时,就很有用了。 - 条件编译:

if cfg!(debug_assertions),说明紧跟其后的输出(打印)只在debug模式下生效。 - 隐式返回:Rust 提供了

return关键字用于函数返回,但是在很多时候,我们可以省略它。因为 Rust 是 基于表达式的语言。

在终端中运行上述代码时,会看到很多 debug: ... 的输出,上面有讲,这些都是 条件编译 的输出,那么该怎么消除掉这些输出呢?

读者大大普遍冰雪聪明,肯定已经想到:是的,在 认识 Cargo 中,曾经介绍过 --release 参数,因为 cargo run 默认是运行 debug 模式。因此想要消灭那些 debug: 输出,需要更改为其它模式,其中最常用的模式就是 --release 也就是生产发布的模式。

具体运行代码就不给了,留给大家作为一个小练习,建议亲自动手尝试下。

至此,Rust 安装入门就已经结束。相信看到这里,你已经发现了本书与其它书的区别,其中最大的区别就是:这本书就像优秀的国外课本一样,不太枯燥。也希望这本不太枯燥的书,能伴你长行,犹如一杯奶茶,细细品之,唇齿留香。

下载依赖很慢或卡住?

在目前,大家还不需要自己搭建的镜像下载服务,因此只需知道下载依赖库的地址是 crates.io,是由 Rust 官方搭建的镜像下载和管理服务。

但悲剧的是,它的默认镜像地址是在国外,这就导致了某些时候难免会遇到下载缓慢或者卡住的情况,下面我们一起来看看。

下载很慢?

作为国外的语言,下载慢是正常的,隔壁的那位还被墙呢:)

解决下载缓慢有两种途径:

开启命令行或者全局翻墙

经常有同学反馈,我明明开启翻墙了,但是下载依然还是很慢,无论是命令行中下载还是 VSCode 的 rust-analyzer 插件自动拉取。

事实上,翻墙工具默认开启的仅仅是浏览器的翻墙代理,对于命令行或者软件中的访问,并不会代理流量,因此这些访问还是通过正常网络进行的,自然会失败。

因此,大家需要做的是在你使用的翻墙工具中 复制终端代理命令 或者开启全局翻墙。由于每个翻墙软件的使用方式不同,因此具体的还是需要自己研究下。以我使用的 ClashX 为例,点击 复制终端代理命令 后,会自动复制一些 export 文本,将这些文本复制到命令行终端中,执行一下,就可以自动完成代理了。

export https_proxy=http://127.0.0.1:7890 http_proxy=http://127.0.0.1:7890 all_proxy=socks5://127.0.0.1:7891

修改 Rust 的下载镜像为国内的镜像地址

这个效果最直接,一劳永逸,但是就是配置起来略微麻烦。

为了使用 crates.io 之外的注册服务,我们需要对 $HOME/.cargo/config.toml ($CARGO_HOME 下) 文件进行配置,添加新的服务提供商,有两种方式可以实现:增加新的镜像地址和覆盖默认的镜像地址。

新增镜像地址

首先是在 crates.io 之外添加新的注册服务,在 $HOME/.cargo/config.toml (如果文件不存在则手动创建一个)中添加以下内容:

[registries]

ustc = { index = "https://mirrors.ustc.edu.cn/crates.io-index/" }

这种方式只会新增一个新的镜像地址,因此在引入依赖的时候,需要指定该地址,例如在项目中引入 time 包,你需要在 Cargo.toml 中使用以下方式引入:

[dependencies]

time = { registry = "ustc" }

在重新配置后,初次构建可能要较久的时间,因为要下载更新 ustc 注册服务的索引文件,由于文件比较大,需要等待较长的时间。

此处有两点需要注意:

- cargo 1.68 版本开始支持稀疏索引,不再需要完整克隆 crates.io-index 仓库,可以加快获取包的速度,如:

[source.ustc]

registry = "sparse+https://mirrors.ustc.edu.cn/crates.io-index/"

- cargo search 无法使用镜像

科大镜像

上面使用的是科大提供的注册服务,也是 Rust 最早期的注册服务,感谢大大们的贡献。除此之外,大家还可以选择下面的镜像服务:

字节跳动

最大的优点就是不限速,当然,你的网速如果能跑到 1000Gbps,我们也可以认为它无情的限制了你,咳咳。

[source.crates-io]

replace-with = 'rsproxy'

[source.rsproxy]

registry = "https://rsproxy.cn/crates.io-index"

# 稀疏索引,要求 cargo >= 1.68

[source.rsproxy-sparse]

registry = "sparse+https://rsproxy.cn/index/"

[registries.rsproxy]

index = "https://rsproxy.cn/crates.io-index"

[net]

git-fetch-with-cli = true

覆盖默认的镜像地址

事实上,我们更推荐第二种方式,因为第一种方式在项目大了后,实在是很麻烦,全部修改后,万一以后不用这个镜像了,你又要全部修改成其它的。

而第二种方式,则不需要修改 Cargo.toml 文件,因为它是直接使用新注册服务来替代默认的 crates.io。

在 $HOME/.cargo/config.toml 添加以下内容:

[source.crates-io]

replace-with = 'ustc'

[source.ustc]

registry = "git://mirrors.ustc.edu.cn/crates.io-index"

首先,创建一个新的镜像源 [source.ustc],然后将默认的 crates-io 替换成新的镜像源: replace-with = 'ustc'。

简单吧?只要这样配置后,以往需要去 crates.io 下载的包,会全部从科大的镜像地址下载,速度刷刷的… 我的 300M 大刀(宽带)终于有了用武之地。

这里强烈推荐大家在学习完后面的基本章节后,看一下 Cargo 使用指南章节,对于你的 Rust 之旅会有莫大的帮助!

下载卡住

下载卡住其实就一个原因:下载太慢了。

根据经验来看,卡住不动往往发生在更新索引时。毕竟 Rust 的包越来越多,索引也越来越大,如果不使用国内镜像,卡住还蛮正常的,好在,我们也无需经常更新索引 :P

Blocking waiting for file lock on package cache

不过这里有一个坑,需要大家注意,如果你同时打开了 VSCODE 和命令行,然后修改了 Cargo.toml,此时 VSCODE 的 rust-analyzer 插件会自动检测到依赖的变更,去下载新的依赖。

在 VSCODE 下载的过程中(特别是更新索引,可能会耗时很久),假如你又在命令行中运行类似 cargo run 或者 cargo build 的命令,就会提示一行有些看不太懂的内容:

$ cargo build

Blocking waiting for file lock on package cache

Blocking waiting for file lock on package cache

其实这个报错就是因为 VSCODE 的下载太慢了,而且该下载构建还锁住了当前的项目,导致你无法在另一个地方再次进行构建。

解决办法也很简单:

- 增加下载速度,见前面内容

- 耐心等待持有锁的用户构建完成

- 强行停止正在构建的进程,例如杀掉 IDE 使用的 rust-analyzer 插件进程,然后删除

$HOME/.cargo/.package_cache目录

Rust 基本概念

从现在开始,我们正式踏入了 Rust 大陆,这片广袤而神秘的世界,在这个世界中,将接触到很多之前都没有听过的概念:

- 所有权、借用、生命周期

- 宏编程

- 模式匹配

类似的还有很多,不过不用怕,引用武林外传一句话:咱上面有人。有本书在,一切虚妄终将烟消云散。

本章主要介绍 Rust 的基础语法、数据类型、项目结构等,学完本章,你将对 Rust 代码有一个清晰、完整的认识。

开始之前先通过一段代码来简单浏览下 Rust 的语法:

// Rust 程序入口函数,跟其它语言一样,都是 main,该函数目前无返回值

fn main() {

// 使用let来声明变量,进行绑定,a是不可变的

// 此处没有指定a的类型,编译器会默认根据a的值为a推断类型:i32,有符号32位整数

// 语句的末尾必须以分号结尾

let a = 10;

// 主动指定b的类型为i32

let b: i32 = 20;

// 这里有两点值得注意:

// 1. 可以在数值中带上类型:30i32表示数值是30,类型是i32

// 2. c是可变的,mut是mutable的缩写

let mut c = 30i32;

// 还能在数值和类型中间添加一个下划线,让可读性更好

let d = 30_i32;

// 跟其它语言一样,可以使用一个函数的返回值来作为另一个函数的参数

let e = add(add(a, b), add(c, d));

// println!是宏调用,看起来像是函数但是它返回的是宏定义的代码块

// 该函数将指定的格式化字符串输出到标准输出中(控制台)

// {}是占位符,在具体执行过程中,会把e的值代入进来

println!("( a + b ) + ( c + d ) = {}", e);

}

// 定义一个函数,输入两个i32类型的32位有符号整数,返回它们的和

fn add(i: i32, j: i32) -> i32 {

// 返回相加值,这里可以省略return

i + j

}注意 在上面的

add函数中,不要为i+j添加;,这会改变语法导致函数返回()而不是i32,具体参见语句和表达式。

有几点可以留意下:

- 字符串使用双引号

""而不是单引号'',Rust 中单引号是留给单个字符类型(char)使用的 - Rust 使用

{}来作为格式化输出占位符,其它语言可能使用的是%s,%d,%p等,由于println!会自动推导出具体的类型,因此无需手动指定

变量绑定与解构

鉴于本书的目标读者(别慌,来到这里就说明你就是目标读者)已经熟练掌握其它任意一门编程语言,因此这里就不再对何为变量进行赘述,让我们开门见山来谈谈,为何 Rust 选择了手动设定变量的可变性。

为何要手动设置变量的可变性?

在其它大多数语言中,要么只支持声明可变的变量,要么只支持声明不可变的变量(例如函数式语言),前者为编程提供了灵活性,后者为编程提供了安全性,而 Rust 比较野,选择了两者我都要,既要灵活性又要安全性。

能想要学习 Rust,说明我们的读者都是相当有水平的程序员了,你们应该能理解一切选择皆是权衡,那么两者都要的权衡是什么呢?这就是 Rust 开发团队为我们做出的贡献,两者都要意味着 Rust 语言底层代码的实现复杂度大幅提升,因此 Salute to The Rust Team!

除了以上两个优点,还有一个很大的优点,那就是运行性能上的提升,因为将本身无需改变的变量声明为不可变在运行期会避免一些多余的 runtime 检查。

变量命名

在命名方面,和其它语言没有区别,不过当给变量命名时,需要遵循 Rust 命名规范。

Rust 语言有一些关键字(keywords),和其他语言一样,这些关键字都是被保留给 Rust 语言使用的,因此,它们不能被用作变量或函数的名称。在 附录 A 中可找到关键字列表。

变量绑定

在其它语言中,我们用 var a = "hello world" 的方式给 a 赋值,也就是把等式右边的 "hello world" 字符串赋值给变量 a ,而在 Rust 中,我们这样写: let a = "hello world" ,同时给这个过程起了另一个名字:变量绑定。

为何不用赋值而用绑定呢(其实你也可以称之为赋值,但是绑定的含义更清晰准确)?这里就涉及 Rust 最核心的原则——所有权,简单来讲,任何内存对象都是有主人的,而且一般情况下完全属于它的主人,绑定就是把这个对象绑定给一个变量,让这个变量成为它的主人(聪明的读者应该能猜到,在这种情况下,该对象之前的主人就会丧失对该对象的所有权),像极了我们的现实世界,不是吗?

那为什么要引进“所有权”这个新的概念呢?请稍安勿躁,时机一旦成熟,我们就回来继续讨论这个话题。

变量可变性

Rust 的变量在默认情况下是不可变的。前文提到,这是 Rust 团队为我们精心设计的语言特性之一,让我们编写的代码更安全,性能也更好。当然你可以通过 mut 关键字让变量变为可变的,让设计更灵活。

如果变量 a 不可变,那么一旦为它绑定值,就不能再修改 a。举个例子,在我们的工程目录下使用 cargo new variables 新建一个项目,叫做 variables 。

然后在新建的 variables 目录下,编辑 src/main.rs ,改为下面代码:

fn main() {

let x = 5;

println!("The value of x is: {}", x);

x = 6;

println!("The value of x is: {}", x);

}保存文件,再使用 cargo run 运行它,迎面而来的是一条错误提示:

$ cargo run

Compiling variables v0.1.0 (file:///projects/variables)

error[E0384]: cannot assign twice to immutable variable `x`

--> src/main.rs:4:5

|

2 | let x = 5;

| -

| |

| first assignment to `x`

| help: consider making this binding mutable: `mut x`

3 | println!("The value of x is: {}", x);

4 | x = 6;

| ^^^^^ cannot assign twice to immutable variable

error: aborting due to previous error

具体的错误原因是 cannot assign twice to immutable variable x(无法对不可变的变量进行重复赋值),因为我们想为不可变的 x 变量再次赋值。

这种错误是为了避免无法预期的错误发生在我们的变量上:一个变量往往被多处代码所使用,其中一部分代码假定该变量的值永远不会改变,而另外一部分代码却无情的改变了这个值,在实际开发过程中,这个错误是很难被发现的,特别是在多线程编程中。

这种规则让我们的代码变得非常清晰,只有你想让你的变量改变时,它才能改变,这样就不会造成心智上的负担,也给别人阅读代码带来便利。

但是可变性也非常重要,否则我们就要像 ClojureScript 那样,每次要改变,就要重新生成一个对象,在拥有大量对象的场景,性能会变得非常低下,内存拷贝的成本异常的高。

在 Rust 中,可变性很简单,只要在变量名前加一个 mut 即可, 而且这种显式的声明方式还会给后来人传达这样的信息:嗯,这个变量在后面代码部分会发生改变。

为了让变量声明为可变,将 src/main.rs 改为以下内容:

fn main() {

let mut x = 5;

println!("The value of x is: {}", x);

x = 6;

println!("The value of x is: {}", x);

}运行程序将得到下面结果:

$ cargo run

Compiling variables v0.1.0 (file:///projects/variables)

Finished dev [unoptimized + debuginfo] target(s) in 0.30s

Running `target/debug/variables`

The value of x is: 5

The value of x is: 6

选择可变还是不可变,更多的还是取决于你的使用场景,例如不可变可以带来安全性,但是丧失了灵活性和性能(如果你要改变,就要重新创建一个新的变量,这里涉及到内存对象的再分配)。而可变变量最大的好处就是使用上的灵活性和性能上的提升。

例如,在使用大型数据结构或者热点代码路径(被大量频繁调用)的情形下,在同一内存位置更新实例可能比复制并返回新分配的实例要更快。使用较小的数据结构时,通常创建新的实例并以更具函数式的风格来编写程序,可能会更容易理解,所以值得以较低的性能开销来确保代码清晰。

使用下划线开头忽略未使用的变量

如果你创建了一个变量却不在任何地方使用它,Rust 通常会给你一个警告,因为这可能会是个 BUG。但是有时创建一个不会被使用的变量是有用的,比如你正在设计原型或刚刚开始一个项目。这时你希望告诉 Rust 不要警告未使用的变量,为此可以用下划线作为变量名的开头:

fn main() {

let _x = 5;

let y = 10;

}使用 cargo run 运行下试试:

warning: unused variable: `y`

--> src/main.rs:3:9

|

3 | let y = 10;

| ^ help: 如果 y 故意不被使用,请添加一个下划线前缀: `_y`

|

= note: `#[warn(unused_variables)]` on by default

可以看到,两个变量都是只有声明,没有使用,但是编译器却独独给出了 y 未被使用的警告,充分说明了 _ 变量名前缀在这里发挥的作用。

值得注意的是,这里编译器还很善意的给出了提示(Rust 的编译器非常强大,这里的提示只是小意思):将 y 修改 _y 即可。这里就不再给出代码,留给大家手动尝试并观察下运行结果。

更多关于 _x 的使用信息,请阅读后面的模式匹配章节。

变量解构

let 表达式不仅仅用于变量的绑定,还能进行复杂变量的解构:从一个相对复杂的变量中,匹配出该变量的一部分内容:

fn main() {

let (a, mut b): (bool,bool) = (true, false);

// a = true,不可变; b = false,可变

println!("a = {:?}, b = {:?}", a, b);

b = true;

assert_eq!(a, b);

}解构式赋值

在 Rust 1.59 版本后,我们可以在赋值语句的左式中使用元组、切片和结构体模式了。

struct Struct {

e: i32

}

fn main() {

let (a, b, c, d, e);

(a, b) = (1, 2);

// _ 代表匹配一个值,但是我们不关心具体的值是什么,因此没有使用一个变量名而是使用了 _

[c, .., d, _] = [1, 2, 3, 4, 5];

Struct { e, .. } = Struct { e: 5 };

assert_eq!([1, 2, 1, 4, 5], [a, b, c, d, e]);

}这种使用方式跟之前的 let 保持了一致性,但是 let 会重新绑定,而这里仅仅是对之前绑定的变量进行再赋值。

需要注意的是,使用 += 的赋值语句还不支持解构式赋值。

这里用到了模式匹配的一些语法,如果大家看不懂没关系,可以在学完模式匹配章节后,再回头来看。

变量和常量之间的差异

变量的值不能更改可能让你想起其他另一个很多语言都有的编程概念:常量(constant)。与不可变变量一样,常量也是绑定到一个常量名且不允许更改的值,但是常量和变量之间存在一些差异:

- 常量不允许使用

mut。常量不仅仅默认不可变,而且自始至终不可变,因为常量在编译完成后,已经确定它的值。 - 常量使用

const关键字而不是let关键字来声明,并且值的类型必须标注。

我们将在下一节数据类型中介绍,因此现在暂时无需关心细节。

下面是一个常量声明的例子,其常量名为 MAX_POINTS,值设置为 100,000。(Rust 常量的命名约定是全部字母都使用大写,并使用下划线分隔单词,另外对数字字面量可插入下划线以提高可读性):

#![allow(unused)]

fn main() {

const MAX_POINTS: u32 = 100_000;

}常量可以在任意作用域内声明,包括全局作用域,在声明的作用域内,常量在程序运行的整个过程中都有效。对于需要在多处代码共享一个不可变的值时非常有用,例如游戏中允许玩家赚取的最大点数或光速。

在实际使用中,最好将程序中用到的硬编码值都声明为常量,对于代码后续的维护有莫大的帮助。如果将来需要更改硬编码的值,你也只需要在代码中更改一处即可。

变量遮蔽(shadowing)

Rust 允许声明相同的变量名,在后面声明的变量会遮蔽掉前面声明的,如下所示:

fn main() {

let x = 5;

// 在main函数的作用域内对之前的x进行遮蔽

let x = x + 1;

{

// 在当前的花括号作用域内,对之前的x进行遮蔽

let x = x * 2;

println!("The value of x in the inner scope is: {}", x);

}

println!("The value of x is: {}", x);

}这个程序首先将数值 5 绑定到 x,然后通过重复使用 let x = 来遮蔽之前的 x,并取原来的值加上 1,所以 x 的值变成了 6。第三个 let 语句同样遮蔽前面的 x,取之前的值并乘上 2,得到的 x 最终值为 12。当运行此程序,将输出以下内容:

$ cargo run

Compiling variables v0.1.0 (file:///projects/variables)

...

The value of x in the inner scope is: 12

The value of x is: 6

这和 mut 变量的使用是不同的,第二个 let 生成了完全不同的新变量,两个变量只是恰好拥有同样的名称,涉及一次内存对象的再分配

,而 mut 声明的变量,可以修改同一个内存地址上的值,并不会发生内存对象的再分配,性能要更好。

变量遮蔽的用处在于,如果你在某个作用域内无需再使用之前的变量(在被遮蔽后,无法再访问到之前的同名变量),就可以重复的使用变量名字,而不用绞尽脑汁去想更多的名字。

例如,假设有一个程序要统计一个空格字符串的空格数量:

#![allow(unused)]

fn main() {

// 字符串类型

let spaces = " ";

// usize数值类型

let spaces = spaces.len();

}这种结构是允许的,因为第一个 spaces 变量是一个字符串类型,第二个 spaces 变量是一个全新的变量且和第一个具有相同的变量名,且是一个数值类型。所以变量遮蔽可以帮我们节省些脑细胞,不用去想如 spaces_str 和 spaces_num 此类的变量名;相反我们可以重复使用更简单的 spaces 变量名。如果你不用 let :

#![allow(unused)]

fn main() {

let mut spaces = " ";

spaces = spaces.len();

}运行一下,你就会发现编译器报错:

$ cargo run

Compiling variables v0.1.0 (file:///projects/variables)

error[E0308]: mismatched types

--> src/main.rs:3:14

|

3 | spaces = spaces.len();

| ^^^^^^^^^^^^ expected `&str`, found `usize`

error: aborting due to previous error

显然,Rust 对类型的要求很严格,不允许将整数类型 usize 赋值给字符串类型。usize 是一种 CPU 相关的整数类型,在数值类型中有详细介绍。

万事开头难,到目前为止,都进展很顺利,那下面开始,咱们正式进入 Rust 的类型世界,看看有哪些挑战在前面等着大家。

课后练习

Rust By Practice,支持代码在线编辑和运行,并提供详细的习题解答。

基本类型

当一门语言不谈类型时,你得小心,这大概率是动态语言(别拍我,我承认是废话)。但是把类型大张旗鼓的用多个章节去讲的,Rust 是其中之一。

Rust 每个值都有其确切的数据类型,总的来说可以分为两类:基本类型和复合类型。基本类型意味着它们往往是一个最小化原子类型,无法解构为其它类型(一般意义上来说),由以下组成:

-

数值类型:

- 有符号整数:

i8,i16,i32,i64,i128,isize - 无符号整数:

u8,u16,u32,u64,u128,usize - 浮点数:

f32(单精度),f64(双精度,默认)

注意:

isize和usize的大小取决于目标平台的指针大小(32 位平台为 4 字节,64 位平台为 8 字节) - 有符号整数:

-

字符串切片:

&str -

布尔类型:

true和false -

字符类型:

char表示单个 Unicode 字符(存储为 4 字节),如'A','中','😻' -

单元类型:

(),其唯一可能的值也是()

类型推导与标注

与 Python、JavaScript 等动态语言不同,Rust 是一门静态类型语言,也就是编译器必须在编译期知道我们所有变量的类型,但这不意味着你需要为每个变量指定类型,因为 Rust 编译器很聪明,它可以根据变量的值和上下文中的使用方式来自动推导出变量的类型,同时编译器也不够聪明,在某些情况下,它无法推导出变量类型,需要手动去给予一个类型标注,关于这一点在 Rust 语言初印象 中有过展示。

来看段代码:

#![allow(unused)]

fn main() {

let guess = "42".parse().expect("Not a number!");

}先忽略 .parse().expect.. 部分,这段代码的目的是将字符串 "42" 进行解析,而编译器在这里无法推导出我们想要的类型:整数?浮点数?字符串?因此编译器会报错:

$ cargo build

Compiling no_type_annotations v0.1.0 (file:///projects/no_type_annotations)

error[E0282]: type annotations needed

--> src/main.rs:2:9

|

2 | let guess = "42".parse().expect("Not a number!");

| ^^^^^ consider giving `guess` a type

因此我们需要提供给编译器更多的信息,例如给 guess 变量一个显式的类型标注:let guess: i32 = ... 或者 "42".parse::<i32>()。

数值类型

我朋友有一个领导(读者:你朋友?黑人问号)说过一句话:所有代码就是 0 和 1 ,简单的很。咱不评价这句话的正确性,但是计算机底层由 01 组成倒是真的。

计算机和数值关联在一起的时间,远比我们想象的要长,因此数值类型可以说是有计算机以来就有的类型,下面内容将深入讨论 Rust 的数值类型以及相关的运算符。

Rust 使用一个相对传统的语法来创建整数(1,2,…)和浮点数(1.0,1.1,…)。整数、浮点数的运算和你在其它语言上见过的一致,都是通过常见的运算符来完成。

不仅仅是数值类型,Rust 也允许在复杂类型上定义运算符,例如在自定义类型上定义

+运算符,这种行为被称为运算符重载,Rust 具体支持的可重载运算符见附录 B。

整数类型

整数是没有小数部分的数字。之前使用过的 i32 类型,表示有符号的 32 位整数( i 是英文单词 integer 的首字母,与之相反的是 u,代表无符号 unsigned 类型)。下表显示了 Rust 中的内置的整数类型:

| 长度 | 有符号类型 | 无符号类型 |

|---|---|---|

| 8 位 | i8 | u8 |

| 16 位 | i16 | u16 |

| 32 位 | i32 | u32 |

| 64 位 | i64 | u64 |

| 128 位 | i128 | u128 |

| 视架构而定 | isize | usize |

类型定义的形式统一为:有无符号 + 类型大小(位数)。无符号数表示数字只能取正数和 0,而有符号则表示数字可以取正数、负数还有 0。就像在纸上写数字一样:当要强调符号时,数字前面可以带上正号或负号;然而,当很明显确定数字为正数时,就不需要加上正号了。有符号数字以补码形式存储。

每个有符号类型规定的数字范围是 -(2n - 1) ~ 2n -

1 - 1,其中 n 是该定义形式的位长度。因此 i8 可存储数字范围是 -(27) ~ 27 - 1,即 -128 ~ 127。无符号类型可以存储的数字范围是 0 ~ 2n - 1,所以 u8 能够存储的数字为 0 ~ 28 - 1,即 0 ~ 255。

此外,isize 和 usize 类型取决于程序运行的计算机 CPU 类型: 若 CPU 是 32 位的,则这两个类型是 32 位的,同理,若 CPU 是 64 位,那么它们则是 64 位。

整型字面量可以用下表的形式书写:

| 数字字面量 | 示例 |

|---|---|

| 十进制 | 98_222 |

| 十六进制 | 0xff |

| 八进制 | 0o77 |

| 二进制 | 0b1111_0000 |

字节 (仅限于 u8) | b'A' |

这么多类型,有没有一个简单的使用准则?答案是肯定的, Rust 整型默认使用 i32,例如 let i = 1,那 i 就是 i32 类型,因此你可以首选它,同时该类型也往往是性能最好的。isize 和 usize 的主要应用场景是用作集合的索引。

整型溢出

假设有一个 u8 ,它可以存放从 0 到 255 的值。那么当你将其修改为范围之外的值,比如 256,则会发生整型溢出。关于这一行为 Rust 有一些有趣的规则:当在 debug 模式编译时,Rust 会检查整型溢出,若存在这些问题,则使程序在编译时 panic(崩溃,Rust 使用这个术语来表明程序因错误而退出)。

在当使用 --release 参数进行 release 模式构建时,Rust 不检测溢出。相反,当检测到整型溢出时,Rust 会按照补码循环溢出(two’s complement wrapping)的规则处理。简而言之,大于该类型最大值的数值会被补码转换成该类型能够支持的对应数字的最小值。比如在 u8 的情况下,256 变成 0,257 变成 1,依此类推。程序不会 panic,但是该变量的值可能不是你期望的值。依赖这种默认行为的代码都应该被认为是错误的代码。

要显式处理可能的溢出,可以使用标准库针对原始数字类型提供的这些方法:

- 使用

wrapping_*方法在所有模式下都按照补码循环溢出规则处理,例如wrapping_add - 如果使用

checked_*方法时发生溢出,则返回None值 - 使用

overflowing_*方法返回该值和一个指示是否存在溢出的布尔值 - 使用

saturating_*方法,可以限定计算后的结果不超过目标类型的最大值或低于最小值,例如:

#![allow(unused)]

fn main() {

assert_eq!(100u8.saturating_add(1), 101);

assert_eq!(u8::MAX.saturating_add(127), u8::MAX);

}下面是一个演示wrapping_*方法的示例:

fn main() {

let a : u8 = 255;

let b = a.wrapping_add(20);

println!("{}", b); // 19

}浮点类型

浮点类型数字 是带有小数点的数字,在 Rust 中浮点类型数字也有两种基本类型: f32 和 f64,分别为 32 位和 64 位大小。默认浮点类型是 f64,在现代的 CPU 中它的速度与 f32 几乎相同,但精度更高。

下面是一个演示浮点数的示例:

fn main() {

let x = 2.0; // f64

let y: f32 = 3.0; // f32

}浮点数根据 IEEE-754 标准实现。f32 类型是单精度浮点型,f64 为双精度。

浮点数陷阱

浮点数由于底层格式的特殊性,导致了如果在使用浮点数时不够谨慎,就可能造成危险,有两个原因:

-

浮点数往往是你想要数字的近似表达 浮点数类型是基于二进制实现的,但是我们想要计算的数字往往是基于十进制,例如

0.1在二进制上并不存在精确的表达形式,但是在十进制上就存在。这种不匹配性导致一定的歧义性,更多的,虽然浮点数能代表真实的数值,但是由于底层格式问题,它往往受限于定长的浮点数精度,如果你想要表达完全精准的真实数字,只有使用无限精度的浮点数才行 -

浮点数在某些特性上是反直觉的 例如大家都会觉得浮点数可以进行比较,对吧?是的,它们确实可以使用

>,>=等进行比较,但是在某些场景下,这种直觉上的比较特性反而会害了你。因为f32,f64上的比较运算实现的是std::cmp::PartialEq特征(类似其他语言的接口),但是并没有实现std::cmp::Eq特征,但是后者在其它数值类型上都有定义,说了这么多,可能大家还是云里雾里,用一个例子来举例:

Rust 的 HashMap 数据结构,是一个 KV 类型的 Hash Map 实现,它对于 K 没有特定类型的限制,但是要求能用作 K 的类型必须实现了 std::cmp::Eq 特征,因此这意味着你无法使用浮点数作为 HashMap 的 Key,来存储键值对,但是作为对比,Rust 的整数类型、字符串类型、布尔类型都实现了该特征,因此可以作为 HashMap 的 Key。

为了避免上面说的两个陷阱,你需要遵守以下准则:

- 避免在浮点数上测试相等性

- 当结果在数学上可能存在未定义时,需要格外的小心

来看个小例子:

fn main() {

// 断言0.1 + 0.2与0.3相等

assert!(0.1 + 0.2 == 0.3);

}你可能以为,这段代码没啥问题吧,实际上它会 panic(程序崩溃,抛出异常),因为二进制精度问题,导致了 0.1 + 0.2 并不严格等于 0.3,它们可能在小数点 N 位后存在误差。

那如果非要进行比较呢?可以考虑用这种方式 (0.1_f64 + 0.2 - 0.3).abs() < 0.00001 ,具体小于多少,取决于你对精度的需求。

讲到这里,相信大家基本已经明白了,为什么操作浮点数时要格外的小心,但是还不够,下面再来一段代码,直接震撼你的灵魂:

fn main() {

let abc: (f32, f32, f32) = (0.1, 0.2, 0.3);

let xyz: (f64, f64, f64) = (0.1, 0.2, 0.3);

println!("abc (f32)");

println!(" 0.1 + 0.2: {:x}", (abc.0 + abc.1).to_bits());

println!(" 0.3: {:x}", (abc.2).to_bits());

println!();

println!("xyz (f64)");

println!(" 0.1 + 0.2: {:x}", (xyz.0 + xyz.1).to_bits());

println!(" 0.3: {:x}", (xyz.2).to_bits());

println!();

assert!(abc.0 + abc.1 == abc.2);

assert!(xyz.0 + xyz.1 == xyz.2);

}运行该程序,输出如下:

abc (f32)

0.1 + 0.2: 3e99999a

0.3: 3e99999a

xyz (f64)

0.1 + 0.2: 3fd3333333333334

0.3: 3fd3333333333333

thread 'main' panicked at 'assertion failed: xyz.0 + xyz.1 == xyz.2',

➥ch2-add-floats.rs.rs:14:5

note: run with `RUST_BACKTRACE=1` environment variable to display

➥a backtrace

仔细看,对 f32 类型做加法时,0.1 + 0.2 的结果是 3e99999a,0.3 也是 3e99999a,因此 f32 下的 0.1 + 0.2 == 0.3 通过测试,但是到了 f64 类型时,结果就不一样了,因为 f64 精度高很多,因此在小数点非常后面发生了一点微小的变化,0.1 + 0.2 以 4 结尾,但是 0.3 以3结尾,这个细微区别导致 f64 下的测试失败了,并且抛出了异常。

是不是blow your mind away? 没关系,在本书的后续章节中类似的直击灵魂的地方还很多,这就是敢号称 Rust语言圣经(Rust Course) 的底气!

NaN

对于数学上未定义的结果,例如对负数取平方根 -42.1.sqrt() ,会产生一个特殊的结果:Rust 的浮点数类型使用 NaN (not a number) 来处理这些情况。

所有跟 NaN 交互的操作,都会返回一个 NaN,而且 NaN 不能用来比较,下面的代码会崩溃:

fn main() {

let x = (-42.0_f32).sqrt();

assert_eq!(x, x);

}出于防御性编程的考虑,可以使用 is_nan() 等方法,可以用来判断一个数值是否是 NaN :

fn main() {

let x = (-42.0_f32).sqrt();

if x.is_nan() {

println!("未定义的数学行为")

}

}数字运算

Rust 支持所有数字类型的基本数学运算:加法、减法、乘法、除法和取模运算。下面代码各使用一条 let 语句来说明相应运算的用法:

fn main() {

// 加法

let sum = 5 + 10;

// 减法

let difference = 95.5 - 4.3;

// 乘法

let product = 4 * 30;

// 除法

let quotient = 56.7 / 32.2;

// 求余

let remainder = 43 % 5;

}这些语句中的每个表达式都使用了数学运算符,并且计算结果为一个值,然后绑定到一个变量上。附录 B 中给出了 Rust 提供的所有运算符的列表。

再来看一个综合性的示例:

fn main() {

// 编译器会进行自动推导,给予twenty i32的类型

let twenty = 20;

// 类型标注

let twenty_one: i32 = 21;

// 通过类型后缀的方式进行类型标注:22是i32类型

let twenty_two = 22i32;

// 只有同样类型,才能运算

let addition = twenty + twenty_one + twenty_two;

println!("{} + {} + {} = {}", twenty, twenty_one, twenty_two, addition);

// 对于较长的数字,可以用_进行分割,提升可读性

let one_million: i64 = 1_000_000;

println!("{}", one_million.pow(2));

// 定义一个f32数组,其中42.0会自动被推导为f32类型

let forty_twos = [

42.0,

42f32,

42.0_f32,

];

// 打印数组中第一个值,并控制小数位为2位

println!("{:.2}", forty_twos[0]);

}位运算

Rust 的位运算基本上和其他语言一样

| 运算符 | 说明 |

|---|---|

| & 位与 | 相同位置均为1时则为1,否则为0 |

| | 位或 | 相同位置只要有1时则为1,否则为0 |

| ^ 异或 | 相同位置不相同则为1,相同则为0 |

| ! 位非 | 把位中的0和1相互取反,即0置为1,1置为0 |

| << 左移 | 所有位向左移动指定位数,右位补0 |

| >> 右移 | 所有位向右移动指定位数,带符号移动(正数补0,负数补1) |

fn main() {

// 无符号8位整数,二进制为00000010

let a: u8 = 2; // 也可以写 let a: u8 = 0b_0000_0010;

// 二进制为00000011

let b: u8 = 3;

// {:08b}:左高右低输出二进制01,不足8位则高位补0

println!("a value is {:08b}", a);

println!("b value is {:08b}", b);

println!("(a & b) value is {:08b}", a & b);

println!("(a | b) value is {:08b}", a | b);

println!("(a ^ b) value is {:08b}", a ^ b);

println!("(!b) value is {:08b}", !b);

println!("(a << b) value is {:08b}", a << b);

println!("(a >> b) value is {:08b}", a >> b);

let mut a = a;

// 注意这些计算符除了!之外都可以加上=进行赋值 (因为!=要用来判断不等于)

a <<= b;

println!("(a << b) value is {:08b}", a);

}对于移位运算,Rust 会检查它是否超出该整型的位数范围,如果超出,则会报错 overflow。比如,一个 8 位的整型,如果试图移位 8 位,就会报错,但如果移位 7 位就不会。Rust 这样做的理由也很简单,如果移位太多,那么这个移位后的数字就是全 0 或者全 1,所以移位操作不如直接写 0 或者 -1,这很可能意味着这里的代码是有问题的。需要注意的是,不论 debug 模式还是 release 模式,Rust 都会检查溢出。

fn main() {

let a: u8 = 255;

let b = a>>7; // ok

let b = a<<7; // ok

let b = a>>8; // overflow

let b = a<<8; // overflow

}序列(Range)

Rust 提供了一个非常简洁的方式,用来生成连续的数值,例如 1..5,生成从 1 到 4 的连续数字,不包含 5 ;1..=5,生成从 1 到 5 的连续数字,包含 5,它的用途很简单,常常用于循环中:

#![allow(unused)]

fn main() {

for i in 1..=5 {

println!("{}",i);

}

}最终程序输出:

1

2

3

4

5

序列只允许用于数字或字符类型,原因是:它们可以连续,同时编译器在编译期可以检查该序列是否为空,字符和数字值是 Rust 中仅有的可以用于判断是否为空的类型。如下是一个使用字符类型序列的例子:

#![allow(unused)]

fn main() {

for i in 'a'..='z' {

println!("{}",i);

}

}使用 As 完成类型转换

Rust 中可以使用 As 来完成一个类型到另一个类型的转换,其最常用于将原始类型转换为其他原始类型,但是它也可以完成诸如将指针转换为地址、地址转换为指针以及将指针转换为其他指针等功能。你可以在这里了解更多相关的知识。

有理数和复数

Rust 的标准库相比其它语言,准入门槛较高,因此有理数和复数并未包含在标准库中:

- 有理数和复数

- 任意大小的整数和任意精度的浮点数

- 固定精度的十进制小数,常用于货币相关的场景

好在社区已经开发出高质量的 Rust 数值库:num。

按照以下步骤来引入 num 库:

- 创建新工程

cargo new complex-num && cd complex-num - 在

Cargo.toml中的[dependencies]下添加一行num = "0.4.0" - 将

src/main.rs文件中的main函数替换为下面的代码 - 运行

cargo run

use num::complex::Complex;

fn main() {

let a = Complex { re: 2.1, im: -1.2 };

let b = Complex::new(11.1, 22.2);

let result = a + b;

println!("{} + {}i", result.re, result.im)

}总结

之前提到过 Rust 的数值类型和运算跟其他语言相似,事实上还是存在一些差异,例如语法差异,再比如:

- Rust 拥有相当多的数值类型. 因此你需要熟悉这些类型所占用的字节数,这样就知道该类型允许的大小范围以及你选择的类型是否能表达负数

- 类型转换必须是显式的. Rust 永远也不会偷偷把你的 16bit 整数转换成 32bit 整数

- Rust 的数值上可以使用方法. 例如你可以用以下方法来将

13.14取整:13.14_f32.round(),在这里我们使用了类型后缀,因为编译器需要知道13.14的具体类型

数值类型的讲解已经基本结束,接下来,来看看字符和布尔类型。

课后练习

Rust By Practice,支持代码在线编辑和运行,并提供详细的习题解答。

字符、布尔、单元类型

这三个类型所处的地位比较尴尬,你说它们重要吧,确实出现的身影不是很多,说它们不重要吧,有时候也是不可或缺,而且这三个类型都有一个共同点:简单,因此我们统一放在一起讲。

字符类型(char)

字符,对于没有其它编程经验的新手来说可能不太好理解(没有编程经验敢来学 Rust 的绝对是好汉),但是你可以把它理解为英文中的字母,中文中的汉字。

下面的代码展示了几个颇具异域风情的字符:

fn main() {

let c = 'z';

let z = 'ℤ';

let g = '国';

let heart_eyed_cat = '😻';

}如果大家是从有年代感的编程语言过来,可能会大喊一声:这 XX 叫字符?是的,在 Rust 语言中这些都是字符,Rust 的字符不仅仅是 ASCII,所有的 Unicode 值都可以作为 Rust 字符,包括单个的中文、日文、韩文、emoji 表情符号等等,都是合法的字符类型。Unicode 值的范围从 U+0000 ~ U+D7FF 和 U+E000 ~ U+10FFFF。不过“字符”并不是 Unicode 中的一个概念,所以人在直觉上对“字符”的理解和 Rust 的字符概念并不一致。

char类型表示一个 Unicode 标量值(Unicode Scalar Value),它占用固定的 4 字节(32 位) 内存(与 UTF-32 编码单元一致):

fn main() {

let x = '中';

println!("字符'中'占用了{}字节的内存大小", size_of_val(&x));

}输出如下:

$ cargo run

Compiling ...

字符'中'占用了4字节的内存大小

注意,我们还没开始讲字符串,但是这里提前说一下,和一些语言不同,Rust 的字符只能用

''来表示,""是留给字符串的。

布尔(bool)

Rust 中的布尔类型有两个可能的值:true 和 false,布尔值占用内存的大小为 1 个字节:

fn main() {

let t = true;

let f: bool = false; // 使用类型标注,显式指定f的类型

if f {

println!("这是段毫无意义的代码");

}

}使用布尔类型的场景主要在于流程控制,例如上述代码的中的 if 就是其中之一。

单元类型(unit)

单元类型就是 () ,对,你没看错,就是 () ,唯一的值也是 () ,一些读者读到这里可能就不愿意了,你也太敷衍了吧,管这叫类型?

只能说,再不起眼的东西,都有其用途,在目前为止的学习过程中,大家已经看到过很多次 fn main() 函数的使用吧?那么这个函数返回什么呢?

没错, main 函数就返回这个单元类型 (),因此 main 函数有返回值,而没有返回值的函数在 Rust 中是有单独的定义的:发散函数( diverging functions )(-> !),顾名思义,无法收敛的函数。

例如常见的 println!() 的返回值也是单元类型 ()。

再比如,你可以用 () 作为 map 的值,表示我们不关注具体的值,只关注 key。 这种用法和 Go 语言的 struct{} 类似,可以作为一个值用来占位,但是完全不占用任何内存,内存占用为0字节。

课后练习

Rust By Practice,支持代码在线编辑和运行,并提供详细的习题解答。

语句和表达式

Rust 的函数体是由一系列语句组成,最后由一个表达式来返回值,例如:

#![allow(unused)]

fn main() {

fn add_with_extra(x: i32, y: i32) -> i32 {

let x = x + 1; // 语句

let y = y + 5; // 语句

x + y // 表达式

}

}语句会执行一些操作但是不会返回一个值,而表达式会在求值后返回一个值,因此在上述函数体的三行代码中,前两行是语句,最后一行是表达式。

对于 Rust 语言而言,这种基于语句(statement)和表达式(expression)的方式是非常重要的,你需要能明确的区分这两个概念,但是对于很多其它语言而言,这两个往往无需区分。基于表达式是函数式语言的重要特征,表达式总要返回值。

其实,在此之前,我们已经多次使用过语句和表达式。

语句

#![allow(unused)]

fn main() {

let a = 8;

let b: Vec<f64> = Vec::new();

let (a, c) = ("hi", false);

}以上都是语句,它们完成了一个具体的操作,但是并没有返回值,因此是语句。

由于 let 是语句,因此不能将 let 语句赋值给其它值,如下形式是错误的:

#![allow(unused)]

fn main() {

let b = (let a = 8);

}错误如下:

error: expected expression, found `let` statement // 期望表达式,却发现`let`语句

--> src/main.rs:3:10

|

3 | let b = (let a = 8);

| ^^^

|

= note: only supported directly in conditions of `if` and `while` expressions // 允许通过 if let 和 while let 语法进行模式匹配

以上的错误告诉我们 let 是语句,不是表达式,因此它不返回值,也就不能给其它变量赋值。试图将 let 语句作为值赋给变量,违反了语法规则。

表达式

表达式会进行求值,然后返回一个值。例如 5 + 6,在求值后,返回值 11,因此它就是一条表达式。

表达式可以成为语句的一部分,例如 let y = 6 中,6 就是一个表达式,它在求值后返回一个值 6(有些反直觉,但是确实是表达式)。

调用一个函数是表达式,因为会返回一个值,调用宏也是表达式,用花括号包裹最终返回一个值的语句块也是表达式,总之,能返回值,它就是表达式:

fn main() {

let y = {

let x = 3;

x + 1

};

println!("The value of y is: {}", y);

}上面使用一个语句块表达式将值赋给 y 变量,语句块长这样:

#![allow(unused)]

fn main() {

{

let x = 3;

x + 1

}

}该语句块是表达式的原因是:它的最后一行是表达式,返回了 x + 1 的值,注意 x + 1 不能以分号结尾,否则就会从表达式变成语句, 表达式不能包含分号。这一点非常重要,一旦你在表达式后加上分号,它就会变成一条语句,再也不会返回一个值,请牢记!

最后,表达式如果不返回任何值,会隐式地返回一个 () 。

fn main() {

assert_eq!(ret_unit_type(), ())

}

fn ret_unit_type() {

let x = 1;

// if 语句块也是一个表达式,因此可以用于赋值,也可以直接返回

// 类似三元运算符,在Rust里我们可以这样写

let y = if x % 2 == 1 {

"odd"

} else {

"even"

};

// 或者写成一行

let z = if x % 2 == 1 { "odd" } else { "even" };

}课后练习

Rust By Practice,支持代码在线编辑和运行,并提供详细的习题解答。

函数

Rust 的函数我们在之前已经见过不少,跟其他语言几乎没有什么区别。因此本章的学习之路将轻松和愉快,骚年们,请珍惜这种愉快,下一章你将体验到不一样的 Rust。

在函数界,有一个函数只闻其名不闻其声,可以止小孩啼!在程序界只有 hello,world! 可以与之媲美,它就是 add 函数:

#![allow(unused)]

fn main() {

fn add(i: i32, j: i32) -> i32 {

i + j

}

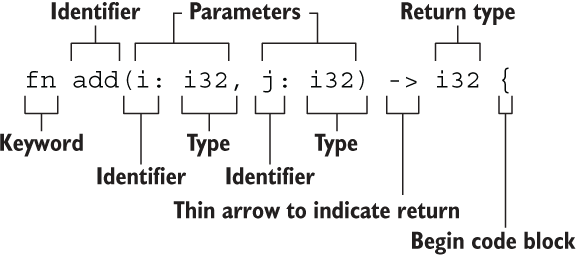

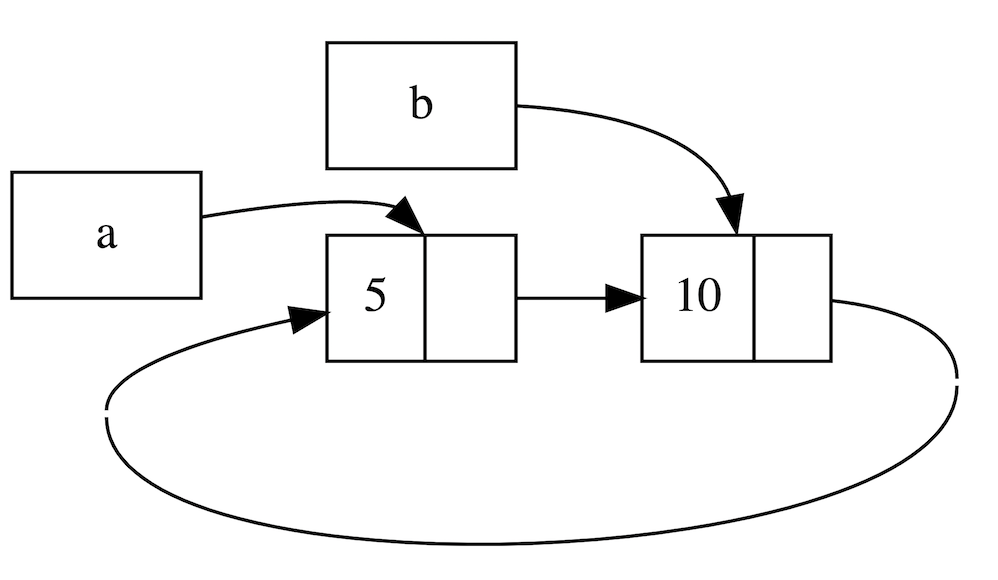

}该函数如此简单,但是又是如此的五脏俱全,声明函数的关键字 fn,函数名 add(),参数 i 和 j,参数类型和返回值类型都是 i32,总之一切那么的普通,但是又那么的自信,直到你看到了下面这张图:

当你看懂了这张图,其实就等于差不多完成了函数章节的学习,但是这么短的章节显然对不起读者老爷们的厚爱,所以我们来展开下。

函数要点

- 函数名和变量名使用蛇形命名法(snake case),例如

fn add_two() {} - 函数的位置可以随便放,Rust 不关心我们在哪里定义了函数,只要有定义即可

- 每个函数参数都需要标注类型

函数参数

Rust 是静态类型语言,因此需要你为每一个函数参数都标识出它的具体类型,例如:

fn main() {

another_function(5, 6.1);

}

fn another_function(x: i32, y: f32) {

println!("The value of x is: {}", x);

println!("The value of y is: {}", y);

}another_function 函数有两个参数,其中 x 是 i32 类型,y 是 f32 类型,然后在该函数内部,打印出这两个值。这里去掉 x 或者 y 的任何一个的类型,都会报错:

fn main() {

another_function(5, 6.1);

}

fn another_function(x: i32, y) {

println!("The value of x is: {}", x);

println!("The value of y is: {}", y);

}错误如下:

error: expected one of `:`, `@`, or `|`, found `)`

--> src/main.rs:5:30

|

5 | fn another_function(x: i32, y) {

| ^ expected one of `:`, `@`, or `|` // 期待以下符号之一 `:`, `@`, or `|`

|

= note: anonymous parameters are removed in the 2018 edition (see RFC 1685)

// 匿名参数在 Rust 2018 edition 中就已经移除

help: if this is a parameter name, give it a type // 如果y是一个参数名,请给予它一个类型

|

5 | fn another_function(x: i32, y: TypeName) {

| ~~~~~~~~~~~

help: if this is a type, explicitly ignore the parameter name // 如果y是一个类型,请使用_忽略参数名

|

5 | fn another_function(x: i32, _: y) {

| ~~~~

函数返回

在上一章节语句和表达式中,我们有提到,在 Rust 中函数就是表达式,因此我们可以把函数的返回值直接赋给调用者。

函数的返回值就是函数体最后一条表达式的返回值,当然我们也可以使用 return 提前返回,下面的函数使用最后一条表达式来返回一个值:

fn plus_five(x:i32) -> i32 {

x + 5

}

fn main() {

let x = plus_five(5);

println!("The value of x is: {}", x);

}x + 5 是一条表达式,求值后,返回一个值,因为它是函数的最后一行,因此该表达式的值也是函数的返回值。

再来看两个重点:

let x = plus_five(5),说明我们用一个函数的返回值来初始化x变量,因此侧面说明了在 Rust 中函数也是表达式,这种写法等同于let x = 5 + 5;x + 5没有分号,因为它是一条表达式,这个在上一节中我们也有详细介绍

再来看一段代码,同时使用 return 和表达式作为返回值:

fn plus_or_minus(x:i32) -> i32 {

if x > 5 {

return x - 5

}

x + 5

}

fn main() {

let x = plus_or_minus(5);

println!("The value of x is: {}", x);

}plus_or_minus 函数根据传入 x 的大小来决定是做加法还是减法,若 x > 5 则通过 return 提前返回 x - 5 的值,否则返回 x + 5 的值。

Rust 中的特殊返回类型

无返回值()

对于 Rust 新手来说,有些返回类型很难理解,而且如果你想通过百度或者谷歌去搜索,都不好查询,因为这些符号太常见了,根本难以精确搜索到。

例如单元类型 (),是一个零长度的元组。它没啥作用,但是可以用来表达一个函数没有返回值:

- 函数没有返回值,那么返回一个

() - 通过

;结尾的语句返回一个()

例如下面的 report 函数会隐式返回一个 ():

#![allow(unused)]

fn main() {

use std::fmt::Debug;

fn report<T: Debug>(item: T) {

println!("{:?}", item);

}

}与上面的函数返回值相同,但是下面的函数显式的返回了 ():

#![allow(unused)]

fn main() {

fn clear(text: &mut String) -> () {

*text = String::from("");

}

}在实际编程中,你会经常在错误提示中看到该 () 的身影出没,假如你的函数需要返回一个 u32 值,但是如果你不幸的以 表达式; 的语句形式作为函数的最后一行代码,就会报错:

#![allow(unused)]

fn main() {

fn add(x:u32,y:u32) -> u32 {

x + y;

}

}错误如下:

error[E0308]: mismatched types // 类型不匹配

--> src/main.rs:6:24

|

6 | fn add(x:u32,y:u32) -> u32 {

| --- ^^^ expected `u32`, found `()` // 期望返回u32,却返回()

| |

| implicitly returns `()` as its body has no tail or `return` expression

7 | x + y;

| - help: consider removing this semicolon

还记得我们在语句与表达式中讲过的吗?只有表达式能返回值,而 ; 结尾的是语句,在 Rust 中,一定要严格区分表达式和语句的区别,这个在其它语言中往往是被忽视的点。

永不返回的发散函数 !

当用 ! 作函数返回类型的时候,表示该函数永不返回( diverging functions ),特别的,这种语法往往用做会导致程序崩溃的函数:

#![allow(unused)]

fn main() {

fn dead_end() -> ! {

panic!("你已经到了穷途末路,崩溃吧!");

}

}下面的函数创建了一个无限循环,该循环永不跳出,因此函数也永不返回:

#![allow(unused)]

fn main() {

fn forever() -> ! {

loop {

//...

};

}

}课后练习

Rust By Practice,支持代码在线编辑和运行,并提供详细的习题解答。

所有权和借用

Rust 之所以能成为万众瞩目的语言,就是因为其内存安全性。在以往,内存安全几乎都是通过 GC 的方式实现,但是 GC 会引来性能、内存占用以及 Stop the world 等问题,在高性能场景和系统编程上是不可接受的,因此 Rust 采用了与 ( 不 ) 众 ( 咋 ) 不 ( 好 ) 同 ( 学 )的方式:所有权系统。

理解所有权和借用,对于 Rust 学习是至关重要的,因此我们把本章提到了非常靠前的位置,So,在座的各位,有一个算一个,准备好了嘛?

从现在开始,鉴于大家已经掌握了非常基本的语法,有些时候,在示例代码中,将省略 fn main() {} 的模版代码,只要将相应的示例放在 fn main() {} 中,即可运行。

所有权

所有的程序都必须和计算机内存打交道,如何从内存中申请空间来存放程序的运行内容,如何在不需要的时候释放这些空间,成了重中之重,也是所有编程语言设计的难点之一。在计算机语言不断演变过程中,出现了三种流派:

- 垃圾回收机制(GC),在程序运行时不断寻找不再使用的内存,典型代表:Java、Go

- 手动管理内存的分配和释放, 在程序中,通过函数调用的方式来申请和释放内存,典型代表:C++

- 通过所有权来管理内存,编译器在编译时会根据一系列规则进行检查

其中 Rust 选择了第三种,最妙的是,这种检查只发生在编译期,因此对于程序运行期,不会有任何性能上的损失。

由于所有权是一个新概念,因此读者需要花费一些时间来掌握它,一旦掌握,海阔天空任你飞跃,在本章,我们将通过 字符串 来引导讲解所有权的相关知识。

一段不安全的代码

先来看看一段来自 C 语言的糟糕代码:

int* foo() {

int a; // 变量a的作用域开始

a = 100;

char *c = "xyz"; // 变量c的作用域开始

return &a;

} // 变量a和c的作用域结束

这段代码虽然可以编译通过,但是其实非常糟糕,变量 a 和 c 都是局部变量,函数结束后将局部变量 a 的地址返回,但局部变量 a 存在栈中,在离开作用域后,a 所申请的栈上内存都会被系统回收,从而造成了 悬空指针(Dangling Pointer) 的问题。这是一个非常典型的内存安全问题,虽然编译可以通过,但是运行的时候会出现错误,很多编程语言都存在。

再来看变量 c,c 的值是常量字符串,存储于常量区,可能这个函数我们只调用了一次,也可能我们不再会使用这个字符串,但 "xyz" 只有当整个程序结束后系统才能回收这片内存。

所以内存安全问题,一直都是程序员非常头疼的问题,好在,在 Rust 中这些问题即将成为历史,因为 Rust 在编译的时候就可以帮助我们发现内存不安全的问题,那 Rust 如何做到这一点呢?

在正式进入主题前,先来一个预热知识。

栈(Stack)与堆(Heap)

栈和堆是编程语言最核心的数据结构,但是在很多语言中,你并不需要深入了解栈与堆。 但对于 Rust 这样的系统编程语言,值是位于栈上还是堆上非常重要,因为这会影响程序的行为和性能。

栈和堆的核心目标就是为程序在运行时提供可供使用的内存空间。

栈

栈按照顺序存储值并以相反顺序取出值,这也被称作后进先出。想象一下一叠盘子:当增加更多盘子时,把它们放在盘子堆的顶部,当需要盘子时,再从顶部拿走。不能从中间也不能从底部增加或拿走盘子!

增加数据叫做进栈,移出数据则叫做出栈。

因为上述的实现方式,栈中的所有数据都必须占用已知且固定大小的内存空间,假设数据大小是未知的,那么在取出数据时,你将无法取到你想要的数据。

堆

与栈不同,对于大小未知或者可能变化的数据,我们需要将它存储在堆上。

当向堆上放入数据时,需要请求一定大小的内存空间。操作系统在堆的某处找到一块足够大的空位,把它标记为已使用,并返回一个表示该位置地址的指针,该过程被称为在堆上分配内存,有时简称为 “分配”(allocating)。

接着,该指针会被推入栈中,因为指针的大小是已知且固定的,在后续使用过程中,你将通过栈中的指针,来获取数据在堆上的实际内存位置,进而访问该数据。

由上可知,堆是一种缺乏组织的数据结构。想象一下去餐馆就座吃饭:进入餐馆,告知服务员有几个人,然后服务员找到一个够大的空桌子(堆上分配的内存空间)并领你们过去。如果有人来迟了,他们也可以通过桌号(栈上的指针)来找到你们坐在哪。

性能区别

在栈上分配内存比在堆上分配内存要快,因为入栈时操作系统无需进行函数调用(或更慢的系统调用)来分配新的空间,只需要将新数据放入栈顶即可。相比之下,在堆上分配内存则需要更多的工作,这是因为操作系统必须首先找到一块足够存放数据的内存空间,接着做一些记录为下一次分配做准备,如果当前进程分配的内存页不足时,还需要进行系统调用来申请更多内存。 因此,处理器在栈上分配数据会比在堆上分配数据更加高效。

所有权与堆栈

当你的代码调用一个函数时,传递给函数的参数(包括可能指向堆上数据的指针和函数的局部变量)依次被压入栈中,当函数调用结束时,这些值将被从栈中按照相反的顺序依次移除。

因为堆上的数据缺乏组织,因此跟踪这些数据何时分配和释放是非常重要的,否则堆上的数据将产生内存泄漏 —— 这些数据将永远无法被回收。这就是 Rust 所有权系统为我们提供的强大保障。

对于其他很多编程语言,你确实无需理解堆栈的原理,但是在 Rust 中,明白堆栈的原理,对于我们理解所有权的工作原理会有很大的帮助。

所有权原则

理解了堆栈,接下来看一下关于所有权的规则,首先请谨记以下规则:

- Rust 中每一个值都被一个变量所拥有,该变量被称为值的所有者

- 一个值同时只能被一个变量所拥有,或者说一个值只能拥有一个所有者

- 当所有者(变量)离开作用域范围时,这个值将被丢弃(drop)

变量作用域

作用域是一个变量在程序中有效的范围,假如有这样一个变量:

#![allow(unused)]

fn main() {

let s = "hello";

}变量 s 绑定到了一个字符串字面值,该字符串字面值是硬编码到程序代码中的。s 变量从声明的点开始直到当前作用域的结束都是有效的:

#![allow(unused)]

fn main() {

{ // s 在这里无效,它尚未声明

let s = "hello"; // 从此处起,s 是有效的

// 使用 s

} // 此作用域已结束,s不再有效

}简而言之,s 从创建开始就有效,然后有效期持续到它离开作用域为止,可以看出,就作用域来说,Rust 语言跟其他编程语言没有区别。

简单介绍 String 类型

之前提到过,本章会用 String 作为例子,因此这里会进行一下简单的介绍,具体的 String 学习请参见 String 类型。

我们已经见过字符串字面值 let s = "hello",s 是被硬编码进程序里的字符串值(类型为 &str )。字符串字面值是很方便的,但是它并不适用于所有场景。原因有二:

- 字符串字面值是不可变的,因为被硬编码到程序代码中

- 并非所有字符串的值都能在编写代码时得知

例如,字符串是需要程序运行时,通过用户动态输入然后存储在内存中的,这种情况,字符串字面值就完全无用武之地。 为此,Rust 为我们提供动态字符串类型: String,该类型被分配到堆上,因此可以动态伸缩,也就能存储在编译时大小未知的文本。

可以使用下面的方法基于字符串字面量来创建 String 类型:

#![allow(unused)]

fn main() {

let s = String::from("hello");

}:: 是一种调用操作符,这里表示调用 String 类型中的 from 关联函数,由于 String 类型存储在堆上,因此它是动态的,你可以这样修改:

#![allow(unused)]

fn main() {

let mut s = String::from("hello");

s.push_str(", world!"); // push_str() 在字符串后追加字面值

println!("{}", s); // 将打印 `hello, world!`

}言归正传,了解 String 后,一起来看看关于所有权的交互。

变量绑定背后的数据交互

转移所有权

先来看一段代码:

#![allow(unused)]

fn main() {

let x = 5;

let y = x;

}这段代码并没有发生所有权的转移,原因很简单: 代码首先将 5 绑定到变量 x,接着拷贝 x 的值赋给 y,最终 x 和 y 都等于 5,因为整数是 Rust 基本数据类型,是固定大小的简单值,因此这两个值都是通过自动拷贝的方式来赋值的,都被存在栈中,完全无需在堆上分配内存。

整个过程中的赋值都是通过值拷贝的方式完成(发生在栈中),因此并不需要所有权转移。

可能有同学会有疑问:这种拷贝不消耗性能吗?实际上,这种栈上的数据足够简单,而且拷贝非常非常快,只需要复制一个整数大小(

i32,4 个字节)的内存即可,因此在这种情况下,拷贝的速度远比在堆上创建内存来得快的多。实际上,上一章我们讲到的 Rust 基本类型都是通过自动拷贝的方式来赋值的,就像上面代码一样。

然后再来看一段代码:

#![allow(unused)]

fn main() {

let s1 = String::from("hello");

let s2 = s1;

}此时,可能某个大聪明( 善意昵称 )已经想到了:嗯,上面一样,把 s1 的内容拷贝一份赋值给 s2,实际上,并不是这样。之前也提到了,对于基本类型(存储在栈上),Rust 会自动拷贝,但是 String 不是基本类型,而且是存储在堆上的,因此不能自动拷贝。

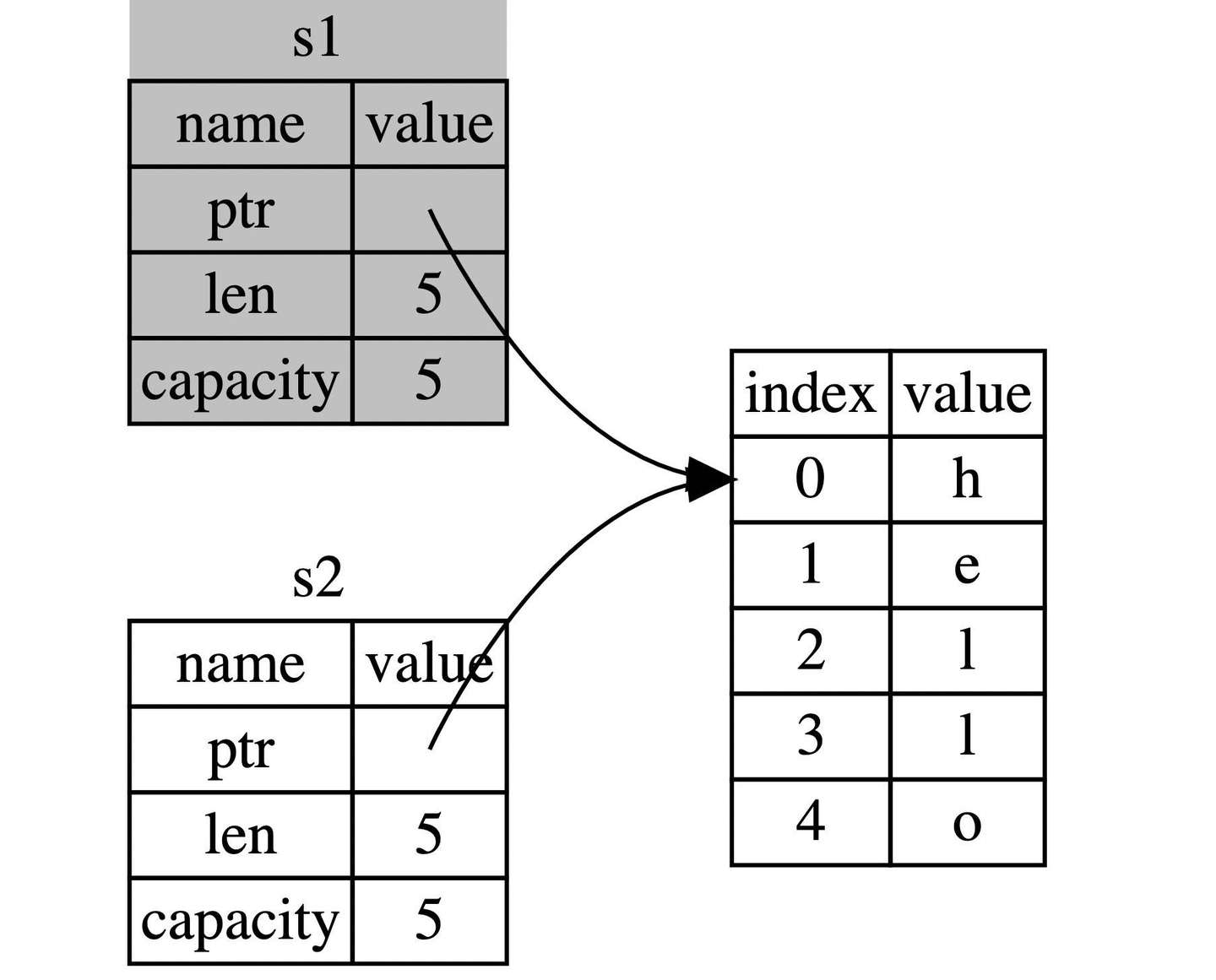

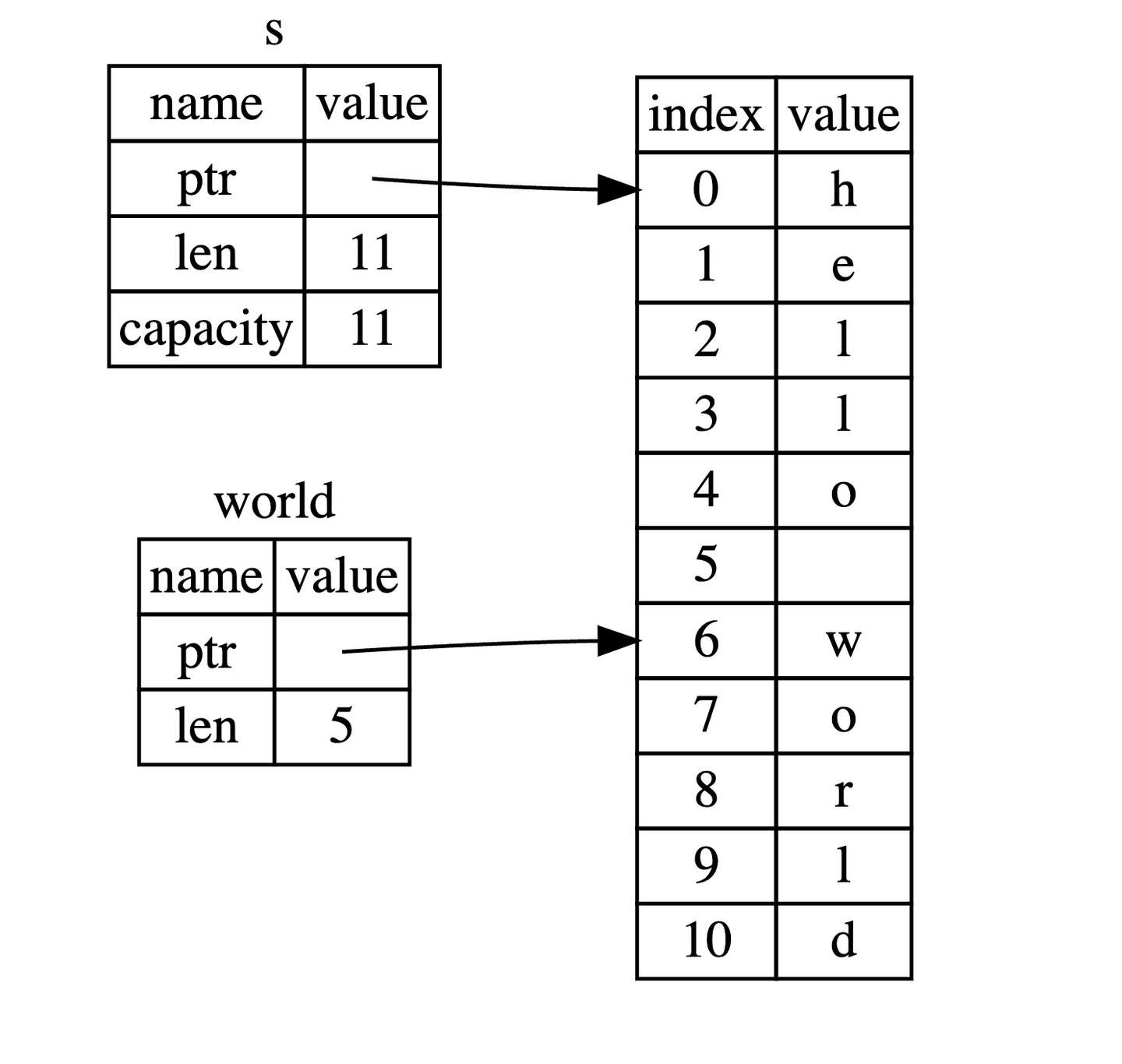

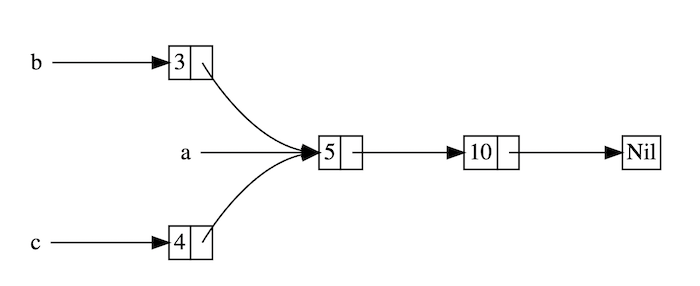

实际上, String 类型是一个复杂类型,由存储在栈中的堆指针、字符串长度、字符串容量共同组成,其中堆指针是最重要的,它指向了真实存储字符串内容的堆内存,至于长度和容量,如果你有 Go 语言的经验,这里就很好理解:容量是堆内存分配空间的大小,长度是目前已经使用的大小。

总之 String 类型指向了一个堆上的空间,这里存储着它的真实数据,下面对上面代码中的 let s2 = s1 分成两种情况讨论:

-

拷贝

String和存储在堆上的字节数组 如果该语句是拷贝所有数据(深拷贝),那么无论是String本身还是底层的堆上数据,都会被全部拷贝,这对于性能而言会造成非常大的影响 -

只拷贝

String本身 这样的拷贝非常快,因为在 64 位机器上就拷贝了8字节的指针、8字节的长度、8字节的容量,总计 24 字节,但是带来了新的问题,还记得我们之前提到的所有权规则吧?其中有一条就是:一个值只允许有一个所有者,而现在这个值(堆上的真实字符串数据)有了两个所有者:s1和s2。

好吧,就假定一个值可以拥有两个所有者,会发生什么呢?

当变量离开作用域后,Rust 会自动调用 drop 函数并清理变量的堆内存。不过由于两个 String 变量指向了同一位置。这就有了一个问题:当 s1 和 s2 离开作用域,它们都会尝试释放相同的内存。这是一个叫做 二次释放(double free) 的错误,也是之前提到过的内存安全性 BUG 之一。两次释放(相同)内存会导致内存污染,它可能会导致潜在的安全漏洞。

因此,Rust 这样解决问题:当 s1 被赋予 s2 后,Rust 认为 s1 不再有效,因此也无需在 s1 离开作用域后 drop 任何东西,这就是把所有权从 s1 转移给了 s2,s1 在被赋予 s2 后就马上失效了。

再来看看,在所有权转移后再来使用旧的所有者,会发生什么:

#![allow(unused)]

fn main() {

let s1 = String::from("hello");

let s2 = s1;

println!("{}, world!", s1);

}由于 Rust 禁止你使用无效的引用,你会看到以下的错误:

error[E0382]: borrow of moved value: `s1`

--> src/main.rs:5:28

|

2 | let s1 = String::from("hello");

| -- move occurs because `s1` has type `String`, which does not implement the `Copy` trait

3 | let s2 = s1;

| -- value moved here

4 |

5 | println!("{}, world!", s1);

| ^^ value borrowed here after move

|

= note: this error originates in the macro `$crate::format_args_nl` which comes from the expansion of the macro `println` (in Nightly builds, run with -Z macro-backtrace for more info)

help: consider cloning the value if the performance cost is acceptable

|

3 | let s2 = s1.clone();

| ++++++++

For more information about this error, try `rustc --explain E0382`.

现在再回头看看之前的规则,相信大家已经有了更深刻的理解:

- Rust 中每一个值都被一个变量所拥有,该变量被称为值的所有者

- 一个值同时只能被一个变量所拥有,或者说一个值只能拥有一个所有者

- 当所有者(变量)离开作用域范围时,这个值将被丢弃(drop)

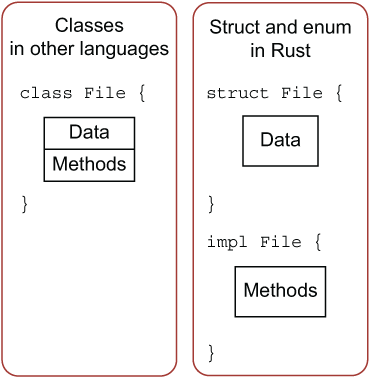

如果你在其他语言中听说过术语 浅拷贝(shallow copy) 和 深拷贝(deep copy),那么拷贝指针、长度和容量而不拷贝数据听起来就像浅拷贝,但是又因为 Rust 同时使第一个变量 s1 无效了,因此这个操作被称为 移动(move),而不是浅拷贝。上面的例子可以解读为 s1 被移动到了 s2 中。那么具体发生了什么,用一张图简单说明:

这样就解决了我们之前的问题,s1 不再指向任何数据,只有 s2 是有效的,当 s2 离开作用域,它就会释放内存。 相信此刻,你应该明白了,为什么 Rust 称呼 let a = b 为变量绑定了吧?

再来看一段代码:

fn main() {

let x: &str = "hello, world";

let y = x;

println!("{},{}",x,y);

}这段代码,大家觉得会否报错?如果参考之前的 String 所有权转移的例子,那这段代码也应该报错才是,但是实际上呢?

这段代码和之前的 String 有一个本质上的区别:在 String 的例子中 s1 持有了通过String::from("hello") 创建的值的所有权,而这个例子中,x 只是引用了存储在二进制可执行文件( binary )中的字符串 "hello, world",并没有持有所有权。

因此 let y = x 中,仅仅是对该引用进行了拷贝,此时 y 和 x 都引用了同一个字符串。如果还不理解也没关系,当学习了下一章节 “引用与借用” 后,大家自然而言就会理解。

克隆(深拷贝)

首先,Rust 永远也不会自动创建数据的 “深拷贝”。因此,任何自动的复制都不是深拷贝,可以被认为对运行时性能影响较小。

如果我们确实需要深度复制 String 中堆上的数据,而不仅仅是栈上的数据,可以使用一个叫做 clone 的方法。

#![allow(unused)]

fn main() {

let s1 = String::from("hello");

let s2 = s1.clone();

println!("s1 = {}, s2 = {}", s1, s2);

}这段代码能够正常运行,说明 s2 确实完整的复制了 s1 的数据。

如果代码性能无关紧要,例如初始化程序时或者在某段时间只会执行寥寥数次时,你可以使用 clone 来简化编程。但是对于执行较为频繁的代码(热点路径),使用 clone 会极大的降低程序性能,需要小心使用!

拷贝(浅拷贝)

浅拷贝只发生在栈上,因此性能很高,在日常编程中,浅拷贝无处不在。

再回到之前看过的例子:

#![allow(unused)]

fn main() {

let x = 5;

let y = x;

println!("x = {}, y = {}", x, y);

}但这段代码似乎与我们刚刚学到的内容相矛盾:没有调用 clone,不过依然实现了类似深拷贝的效果 —— 没有报所有权的错误。

原因是像整型这样的基本类型在编译时是已知大小的,会被存储在栈上,所以拷贝其实际的值是快速的。这意味着没有理由在创建变量 y 后使 x 无效(x、y 都仍然有效)。换句话说,这里没有深浅拷贝的区别,因此这里调用 clone 并不会与通常的浅拷贝有什么不同,我们可以不用管它(可以理解成在栈上做了深拷贝)。

Rust 有一个叫做 Copy 的特征,可以用在类似整型这样在栈中存储的类型。如果一个类型拥有 Copy 特征,一个旧的变量在被赋值给其他变量后仍然可用,也就是赋值的过程即是拷贝的过程。

那么什么类型是可 Copy 的呢?可以查看给定类型的文档来确认,这里可以给出一个通用的规则: 任何基本类型的组合可以 Copy ,不需要分配内存或某种形式资源的类型是可以 Copy 的。如下是一些 Copy 的类型:

- 所有整数类型,比如

u32 - 布尔类型,

bool,它的值是true和false - 所有浮点数类型,比如

f64 - 字符类型,

char - 元组,当且仅当其包含的类型也都是

Copy的时候。比如,(i32, i32)是Copy的,但(i32, String)就不是 - 不可变引用

&T,例如转移所有权中的最后一个例子,但是注意:可变引用&mut T是不可以 Copy的

函数传值与返回

将值传递给函数,一样会发生 移动 或者 复制,就跟 let 语句一样,下面的代码展示了所有权、作用域的规则:

fn main() {

let s = String::from("hello"); // s 进入作用域

takes_ownership(s); // s 的值移动到函数里 ...

// ... 所以到这里不再有效

let x = 5; // x 进入作用域

makes_copy(x); // x 应该移动函数里,

// 但 i32 是 Copy 的,所以在后面可继续使用 x

} // 这里, x 先移出了作用域,然后是 s。但因为 s 的值已被移走,

// 所以不会有特殊操作

fn takes_ownership(some_string: String) { // some_string 进入作用域

println!("{}", some_string);

} // 这里,some_string 移出作用域并调用 `drop` 方法。占用的内存被释放

fn makes_copy(some_integer: i32) { // some_integer 进入作用域

println!("{}", some_integer);

} // 这里,some_integer 移出作用域。不会有特殊操作你可以尝试在 takes_ownership 之后,再使用 s,看看如何报错?例如添加一行 println!("在move进函数后继续使用s: {}",s);。

同样的,函数返回值也有所有权,例如:

fn main() {

let s1 = gives_ownership(); // gives_ownership 将返回值

// 移给 s1

let s2 = String::from("hello"); // s2 进入作用域

let s3 = takes_and_gives_back(s2); // s2 被移动到

// takes_and_gives_back 中,

// 它也将返回值移给 s3

} // 这里, s3 移出作用域并被丢弃。s2 也移出作用域,但已被移走,

// 所以什么也不会发生。s1 移出作用域并被丢弃

fn gives_ownership() -> String { // gives_ownership 将返回值移动给

// 调用它的函数

let some_string = String::from("hello"); // some_string 进入作用域.

some_string // 返回 some_string 并移出给调用的函数

}

// takes_and_gives_back 将传入字符串并返回该值

fn takes_and_gives_back(a_string: String) -> String { // a_string 进入作用域

a_string // 返回 a_string 并移出给调用的函数

}所有权很强大,避免了内存的不安全性,但是也带来了一个新麻烦: 总是把一个值传来传去来使用它。 传入一个函数,很可能还要从该函数传出去,结果就是语言表达变得非常啰嗦,幸运的是,Rust 提供了新功能解决这个问题。

课后练习

Rust By Practice,支持代码在线编辑和运行,并提供详细的习题解答。

引用与借用

上节中提到,如果仅仅支持通过转移所有权的方式获取一个值,那会让程序变得复杂。 Rust 能否像其它编程语言一样,使用某个变量的指针或者引用呢?答案是可以。

Rust 通过 借用(Borrowing) 这个概念来达成上述的目的,获取变量的引用,称之为借用(borrowing)。正如现实生活中,如果一个人拥有某样东西,你可以从他那里借来,当使用完毕后,也必须要物归原主。

引用与解引用

常规引用是一个指针类型,指向了对象存储的内存地址。在下面代码中,我们创建一个 i32 值的引用 y,然后使用解引用运算符来解出 y 所使用的值:

fn main() {

let x = 5;

let y = &x;

assert_eq!(5, x);

assert_eq!(5, *y);

}变量 x 存放了一个 i32 值 5。y 是 x 的一个引用。可以断言 x 等于 5。然而,如果希望对 y 的值做出断言,必须使用 *y 来解出引用所指向的值(也就是解引用)。一旦解引用了 y,就可以访问 y 所指向的整型值并可以与 5 做比较。

相反如果尝试编写 assert_eq!(5, y);,则会得到如下编译错误:

error[E0277]: can't compare `{integer}` with `&{integer}`

--> src/main.rs:6:5

|

6 | assert_eq!(5, y);

| ^^^^^^^^^^^^^^^^^ no implementation for `{integer} == &{integer}` // 无法比较整数类型和引用类型

|

= help: the trait `std::cmp::PartialEq<&{integer}>` is not implemented for

`{integer}`

不允许比较整数与引用,因为它们是不同的类型。必须使用解引用运算符解出引用所指向的值。

不可变引用

下面的代码,我们用 s1 的引用作为参数传递给 calculate_length 函数,而不是把 s1 的所有权转移给该函数:

fn main() {

let s1 = String::from("hello");

let len = calculate_length(&s1);

println!("The length of '{}' is {}.", s1, len);

}

fn calculate_length(s: &String) -> usize {

s.len()

}能注意到两点:

- 无需像上章一样:先通过函数参数传入所有权,然后再通过函数返回来传出所有权,代码更加简洁

calculate_length的参数s类型从String变为&String

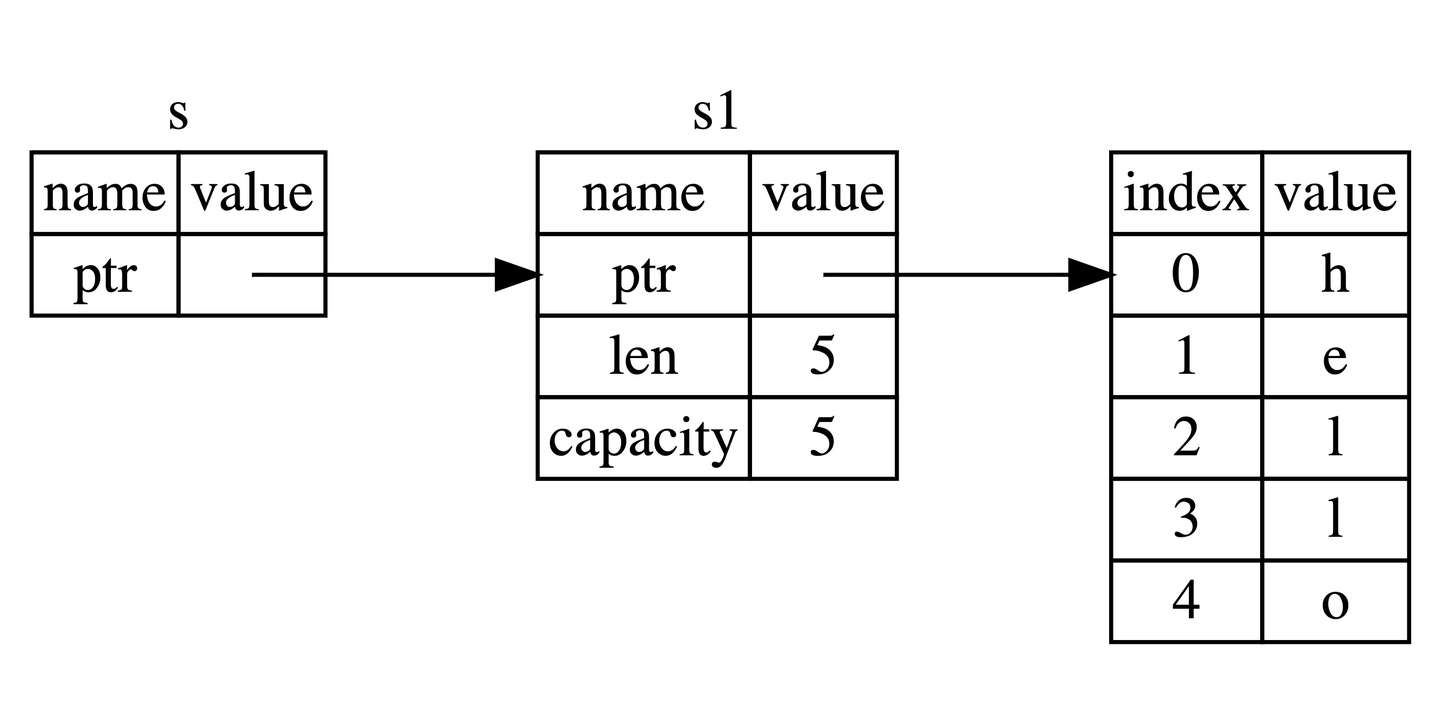

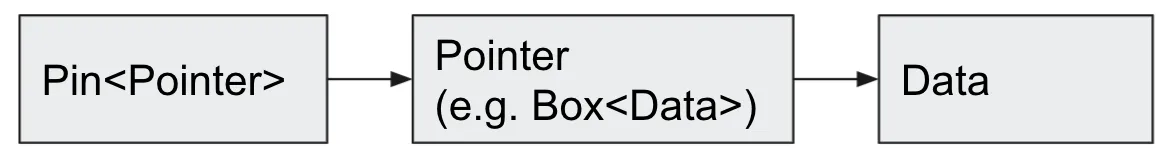

这里,& 符号即是引用,它们允许你使用值,但是不获取所有权,如图所示:

通过 &s1 语法,我们创建了一个指向 s1 的引用,但是并不拥有它。因为并不拥有这个值,当引用离开作用域后,其指向的值也不会被丢弃。

同理,函数 calculate_length 使用 & 来表明参数 s 的类型是一个引用:

#![allow(unused)]

fn main() {

fn calculate_length(s: &String) -> usize { // s 是对 String 的引用

s.len()

} // 这里,s 离开了作用域。但因为它并不拥有引用值的所有权,

// 所以什么也不会发生

}人总是贪心的,可以拉女孩小手了,就想着抱抱柔软的身子(读者中的某老司机表示,这个流程完全不对),因此光借用已经满足不了我们了,如果尝试修改借用的变量呢?

fn main() {

let s = String::from("hello");

change(&s);

}

fn change(some_string: &String) {

some_string.push_str(", world");

}很不幸,妹子你没抱到,哦口误,你修改错了:

error[E0596]: cannot borrow `*some_string` as mutable, as it is behind a `&` reference

--> src/main.rs:8:5

|

7 | fn change(some_string: &String) {

| ------- help: consider changing this to be a mutable reference: `&mut String`

------- 帮助:考虑将该参数类型修改为可变的引用: `&mut String`

8 | some_string.push_str(", world");

| ^^^^^^^^^^^ `some_string` is a `&` reference, so the data it refers to cannot be borrowed as mutable

`some_string`是一个`&`类型的引用,因此它指向的数据无法进行修改

正如变量默认不可变一样,引用指向的值默认也是不可变的,没事,来一起看看如何解决这个问题。

可变引用

只需要一个小调整,即可修复上面代码的错误:

fn main() {

let mut s = String::from("hello");

change(&mut s);

}

fn change(some_string: &mut String) {

some_string.push_str(", world");

}首先,声明 s 是可变类型,其次创建一个可变的引用 &mut s 和接受可变引用参数 some_string: &mut String 的函数。

可变引用同时只能存在一个

不过可变引用并不是随心所欲、想用就用的,它有一个很大的限制: 同一作用域,特定数据只能有一个可变引用:

#![allow(unused)]

fn main() {

let mut s = String::from("hello");

let r1 = &mut s;

let r2 = &mut s;

println!("{}, {}", r1, r2);

}以上代码会报错:

error[E0499]: cannot borrow `s` as mutable more than once at a time 同一时间无法对 `s` 进行两次可变借用

--> src/main.rs:5:14

|

4 | let r1 = &mut s;

| ------ first mutable borrow occurs here 首个可变引用在这里借用

5 | let r2 = &mut s;

| ^^^^^^ second mutable borrow occurs here 第二个可变引用在这里借用

6 |

7 | println!("{}, {}", r1, r2);

| -- first borrow later used here 第一个借用在这里使用

这段代码出错的原因在于,第一个可变借用 r1 必须要持续到最后一次使用的位置 println!,在 r1 创建和最后一次使用之间,我们又尝试创建第二个可变借用 r2。

对于新手来说,这个特性绝对是一大拦路虎,也是新人们谈之色变的编译器 borrow checker 特性之一,不过各行各业都一样,限制往往是出于安全的考虑,Rust 也一样。

这种限制的好处就是使 Rust 在编译期就避免数据竞争,数据竞争可由以下行为造成:

- 两个或更多的指针同时访问同一数据

- 至少有一个指针被用来写入数据

- 没有同步数据访问的机制

数据竞争会导致未定义行为,这种行为很可能超出我们的预期,难以在运行时追踪,并且难以诊断和修复。而 Rust 避免了这种情况的发生,因为它甚至不会编译存在数据竞争的代码!

很多时候,大括号可以帮我们解决一些编译不通过的问题,通过手动限制变量的作用域:

#![allow(unused)]

fn main() {

let mut s = String::from("hello");

{

let r1 = &mut s;

} // r1 在这里离开了作用域,所以我们完全可以创建一个新的引用

let r2 = &mut s;

}可变引用与不可变引用不能同时存在

下面的代码会导致一个错误:

#![allow(unused)]

fn main() {

let mut s = String::from("hello");

let r1 = &s; // 没问题

let r2 = &s; // 没问题

let r3 = &mut s; // 大问题

println!("{}, {}, and {}", r1, r2, r3);

}错误如下:

error[E0502]: cannot borrow `s` as mutable because it is also borrowed as immutable

// 无法借用可变 `s` 因为它已经被借用了不可变

--> src/main.rs:6:14

|

4 | let r1 = &s; // 没问题

| -- immutable borrow occurs here 不可变借用发生在这里

5 | let r2 = &s; // 没问题

6 | let r3 = &mut s; // 大问题

| ^^^^^^ mutable borrow occurs here 可变借用发生在这里

7 |

8 | println!("{}, {}, and {}", r1, r2, r3);

| -- immutable borrow later used here 不可变借用在这里使用

其实这个也很好理解,正在借用不可变引用的用户,肯定不希望他借用的东西,被另外一个人莫名其妙改变了。多个不可变借用被允许是因为没有人会去试图修改数据,每个人都只读这一份数据而不做修改,因此不用担心数据被污染。

注意,引用

r1,r2,r3的作用域从创建开始,一直持续到它最后一次使用的地方println!(....),这个跟变量的作用域有所不同,变量的作用域从创建持续到某一个花括号}

Rust 的编译器一直在优化,早期的时候,引用的作用域跟变量作用域是一致的,这对日常使用带来了很大的困扰,你必须非常小心的去安排可变、不可变变量的借用,免得无法通过编译,例如以下代码:

fn main() {

let mut s = String::from("hello");

let r1 = &s;

let r2 = &s;

println!("{} and {}", r1, r2);

// 新编译器中,r1,r2作用域在这里结束

let r3 = &mut s;

println!("{}", r3);

} // 老编译器中,r1、r2、r3作用域在这里结束

// 新编译器中,r3作用域在这里结束在老版本的编译器中(Rust 1.31 前),将会报错,因为 r1 和 r2 的作用域在花括号 } 处结束,那么 r3 的借用就会触发 无法同时借用可变和不可变 的规则。

但是在新的编译器中,该代码将顺利通过,因为 引用作用域的结束位置从花括号变成最后一次使用的位置,因此 r1 借用和 r2 借用在 println! 后,就结束了,此时 r3 可以顺利借用到可变引用。

NLL

对于这种编译器优化行为,Rust 专门起了一个名字 —— Non-Lexical Lifetimes(NLL),专门用于找到某个引用在作用域(})结束前就不再被使用的代码位置。

虽然这种借用错误有的时候会让我们很郁闷,但是你只要想想这是 Rust 提前帮你发现了潜在的 BUG,其实就开心了,虽然减慢了开发速度,但是从长期来看,大幅减少了后续开发和运维成本。

悬垂引用(Dangling References)

悬垂引用也叫做悬垂指针,意思为指针指向某个值后,这个值被释放掉了,而指针仍然存在,其指向的内存可能不存在任何值或已被其它变量重新使用。在 Rust 中编译器可以确保引用永远也不会变成悬垂状态:当你获取数据的引用后,编译器可以确保数据不会在引用结束前被释放,要想释放数据,必须先停止其引用的使用。

让我们尝试创建一个悬垂引用,Rust 会抛出一个编译时错误:

fn main() {

let reference_to_nothing = dangle();

}

fn dangle() -> &String {

let s = String::from("hello");

&s

}这里是错误:

error[E0106]: missing lifetime specifier

--> src/main.rs:5:16

|

5 | fn dangle() -> &String {

| ^ expected named lifetime parameter

|

= help: this function's return type contains a borrowed value, but there is no value for it to be borrowed from

help: consider using the `'static` lifetime

|

5 | fn dangle() -> &'static String {

| ~~~~~~~~

错误信息引用了一个我们还未介绍的功能:生命周期(lifetimes)。不过,即使你不理解生命周期,也可以通过错误信息知道这段代码错误的关键信息:

this function's return type contains a borrowed value, but there is no value for it to be borrowed from.

该函数返回了一个借用的值,但是已经找不到它所借用值的来源

仔细看看 dangle 代码的每一步到底发生了什么:

#![allow(unused)]

fn main() {

fn dangle() -> &String { // dangle 返回一个字符串的引用

let s = String::from("hello"); // s 是一个新字符串

&s // 返回字符串 s 的引用

} // 这里 s 离开作用域并被丢弃。其内存被释放。

// 危险!

}因为 s 是在 dangle 函数内创建的,当 dangle 的代码执行完毕后,s 将被释放,但是此时我们又尝试去返回它的引用。这意味着这个引用会指向一个无效的 String,这可不对!

其中一个很好的解决方法是直接返回 String:

#![allow(unused)]

fn main() {

fn no_dangle() -> String {

let s = String::from("hello");

s

}

}这样就没有任何错误了,最终 String 的 所有权被转移给外面的调用者。

借用规则总结

总的来说,借用规则如下:

- 同一时刻,你只能拥有要么一个可变引用,要么任意多个不可变引用

- 引用必须总是有效的

课后练习

Rust By Practice,支持代码在线编辑和运行,并提供详细的习题解答。

复合类型

行百里者半九十,欢迎大家来到这里,虽然还不到中点,但是已经不远了。如果说之前学的基础数据类型是原子,那么本章将讲的数据类型可以认为是分子。

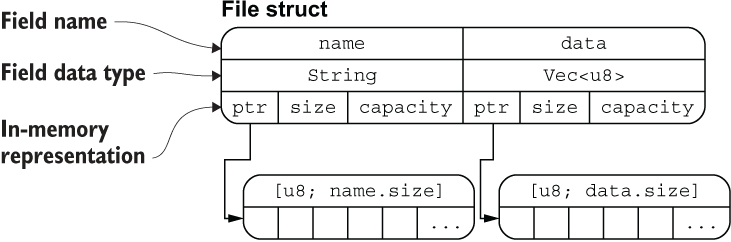

本章的重点在复合类型上,顾名思义,复合类型是由其它类型组合而成的,最典型的就是结构体 struct 和枚举 enum。例如平面上的一个点 point(x, y),它由两个数值类型的值 x 和 y 组合而来。我们无法单独去维护这两个数值,因为单独一个 x 或者 y 是含义不完整的,无法标识平面上的一个点,应该把它们看作一个整体去理解和处理。

来看一段代码,它使用我们之前学过的内容来构建文件操作:

#![allow(unused_variables)]

type File = String;

fn open(f: &mut File) -> bool {

true

}

fn close(f: &mut File) -> bool {

true

}

#[allow(dead_code)]

fn read(f: &mut File, save_to: &mut Vec<u8>) -> ! {

unimplemented!()

}

fn main() {

let mut f1 = File::from("f1.txt");

open(&mut f1);

//read(&mut f1, &mut vec![]);

close(&mut f1);

}接下来我们的学习非常类似原型设计:有的方法只提供 API 接口,但是不提供具体实现。此外,有的变量在声明之后并未使用,因此在这个阶段我们需要排除一些编译器噪音(Rust 在编译的时候会扫描代码,变量声明后未使用会以 warning 警告的形式进行提示),引入 #![allow(unused_variables)] 属性标记,该标记会告诉编译器忽略未使用的变量,不要抛出 warning 警告,具体的常见编译器属性你可以在这里查阅:编译器属性标记。

read 函数也非常有趣,它返回一个 ! 类型,这个表明该函数是一个发散函数,不会返回任何值,包括 ()。unimplemented!() 告诉编译器该函数尚未实现,unimplemented!() 标记通常意味着我们期望快速完成主要代码,回头再通过搜索这些标记来完成次要代码,类似的标记还有 todo!(),当代码执行到这种未实现的地方时,程序会直接报错。你可以反注释 read(&mut f1, &mut vec![]); 这行,然后再观察下结果。

同时,从代码设计角度来看,关于文件操作的类型和函数应该组织在一起,散落得到处都是,是难以管理和使用的。而且通过 open(&mut f1) 进行调用,也远没有使用 f1.open() 来调用好,这就体现出了只使用基本类型的局限性:无法从更高的抽象层次去简化代码。

接下来,我们将引入一个高级数据结构 —— 结构体 struct,来看看复合类型是怎样更好的解决这类问题。 开始之前,先来看看 Rust 的重点也是难点:字符串 String 和 &str。

字符串

在其他语言中,字符串往往是送分题,因为实在是太简单了,例如 "hello, world" 就是字符串章节的几乎全部内容了,但是如果你带着同样的想法来学 Rust,我保证,绝对会栽跟头,因此这一章大家一定要重视,仔细阅读,这里有很多其它 Rust 书籍中没有的内容。

首先来看段很简单的代码:

fn main() {

let my_name = "Pascal";

greet(my_name);

}

fn greet(name: String) {

println!("Hello, {}!", name);

}greet 函数接受字符串类型的 name 参数,打印到终端控制台中,非常好理解。但大家猜猜,这段代码能否通过编译?

error[E0308]: mismatched types

--> src/main.rs:3:11

|

3 | greet(my_name);

| ^^^^^^^

| |

| expected struct `std::string::String`, found `&str`

| help: try using a conversion method: `my_name.to_string()`

error: aborting due to previous error

Bingo,果然报错了,编译器提示 greet 函数需要一个 String 类型的字符串,却传入了一个 &str 类型的字符串,相信读者心中现在一定有几头草泥马呼啸而过,怎么字符串也能整出这么多花活?

在讲解字符串之前,先来看看什么是切片?

切片(slice)

切片并不是 Rust 独有的概念,在 Go 语言中就非常流行,它允许你引用集合中部分连续的元素序列,而不是引用整个集合。

对于字符串而言,切片就是对 String 类型中某一部分的引用,它看起来像这样:

#![allow(unused)]

fn main() {

let s = String::from("hello world");

let hello = &s[0..5];

let world = &s[6..11];

}hello 没有引用整个 String s,而是引用了 s 的一部分内容,通过 [0..5] 的方式来指定。

这就是创建切片的语法,使用方括号包括的一个序列:[开始索引..终止索引],其中开始索引是切片中第一个元素的索引位置,而终止索引是最后一个元素后面的索引位置。换句话说,这是一个 右半开区间(或称为左闭右开区间)——指的是在区间的左端点是包含在内的,而右端点是不包含在内的。在切片数据结构内部会保存开始的位置和切片的长度,其中长度是通过 终止索引 - 开始索引 的方式计算得来的。

对于 let world = &s[6..11]; 来说,world 是一个切片,该切片的指针指向 s 的第 7 个字节(索引从 0 开始, 6 是第 7 个字节),且该切片的长度是 5 个字节。

在使用 Rust 的 .. range 序列语法时,如果你想从索引 0 开始,可以使用如下的方式,这两个是等效的:

#![allow(unused)]

fn main() {

let s = String::from("hello");

let slice = &s[0..2];

let slice = &s[..2];

}同样的,如果你的切片想要包含 String 的最后一个字节,则可以这样使用:

#![allow(unused)]

fn main() {

let s = String::from("hello");

let len = s.len();

let slice = &s[4..len];

let slice = &s[4..];

}你也可以截取完整的 String 切片:

#![allow(unused)]

fn main() {

let s = String::from("hello");

let len = s.len();